表現のための機械学習(というかディープラーニング)がじわじわと来ている、と勝手に思っている。実際、グラフィックス系のカンファレンスでもディープラーニングのセッションが大盛況だし。

クリエイターが機械学習の恩恵を受けられるアプリケーションは、Adobe Senseiみたいに既存ツールの拡張機能という形で普及していくと思っていたけど、単独のアプリケーションも登場していますね。

Runway ML

クリエイターのための機械学習ツール。

あなたの創作活動に人工知能の力を、直感的でシンプルなビジュアルインターフェースで提供します。

さあ、今日から新しい創作方法を始めましょう。

Runwayは、あらゆるジャンルのクリエイターが機械学習を直感的に利用できるプラットフォームです。

要するに、非プログラマーでも機械学習の恩恵を受けられるツール。

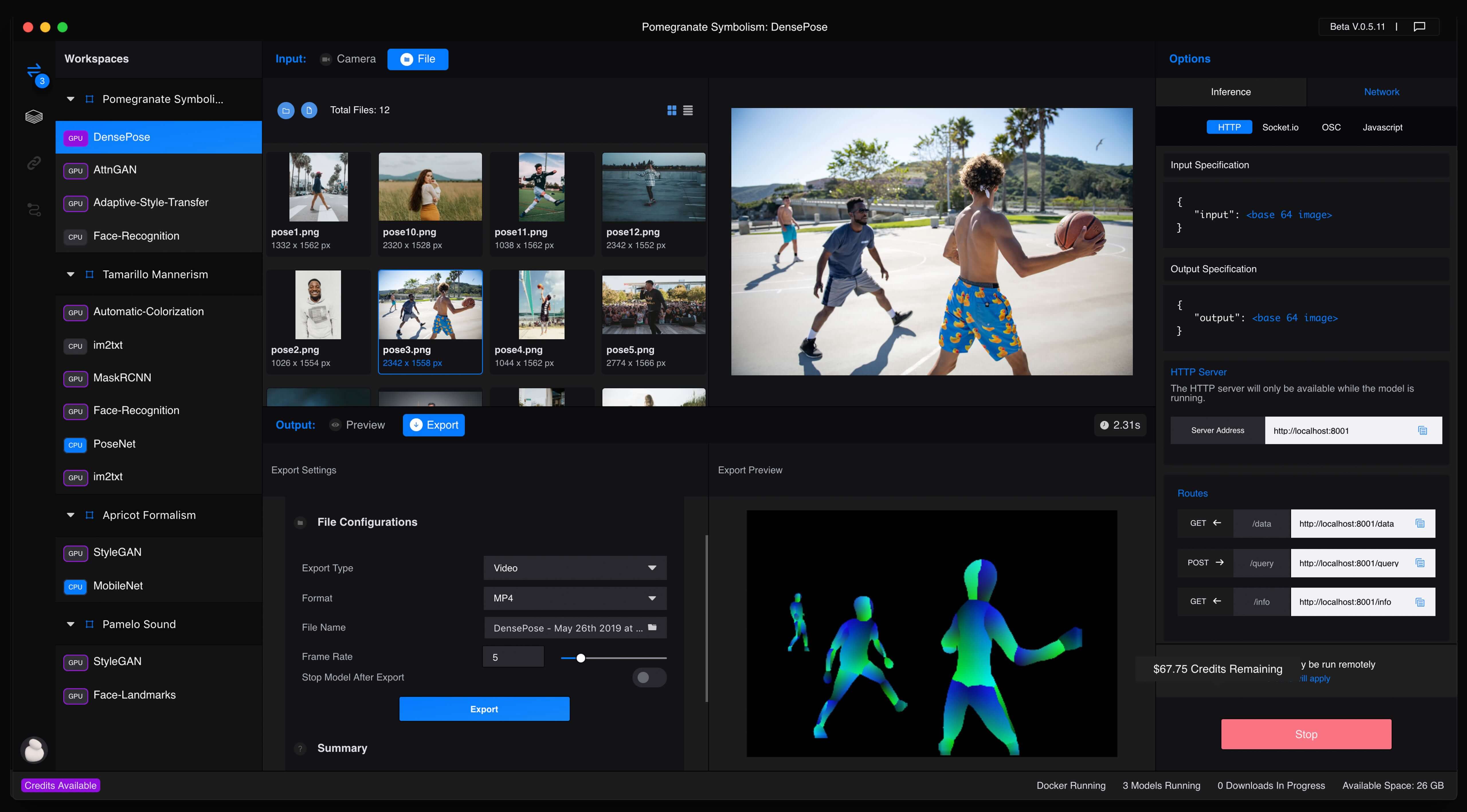

まだベータ版ですが、Runway MLはMac, Windows, Linux環境で使える機械学習アプリケーション。

現在は完全なクラウドアプリになりました。

NIPS 2018のセッションでも紹介されていたようですね。

GUI操作だけでModels Directoryから様々な機械学習手法の学習済みモデルを検索でき、アセットとして利用できる。

現在のBeta Programでは、アカウント登録すると10ドル分のGPUクレジットがもらえる。GPU利用時間1分あたり5セントらしい。

クラウドGPUではなく、ローカルで実行する場合は別途Dockerのインストールが必要。(モデルによってはクラウドGPUでしか実行できないものもあるようです)

Pythonで使えるRunway Model SDKも用意されており、既存のモデルをRunway MLへ持ってくることもできるらしい。

https://github.com/runwayml/model-sdk

また、公式のGitHubリポジトリにはUniy, Processing, TouchDesigner, arduinoなどからRunway MLを利用するサンプルが公開されている。

モノクロ映像のカラー化

ということで、公式ドキュメントを読みながらRunway MLに触ってみた。インストール方法に従ってオイラはWindows環境でインストール。

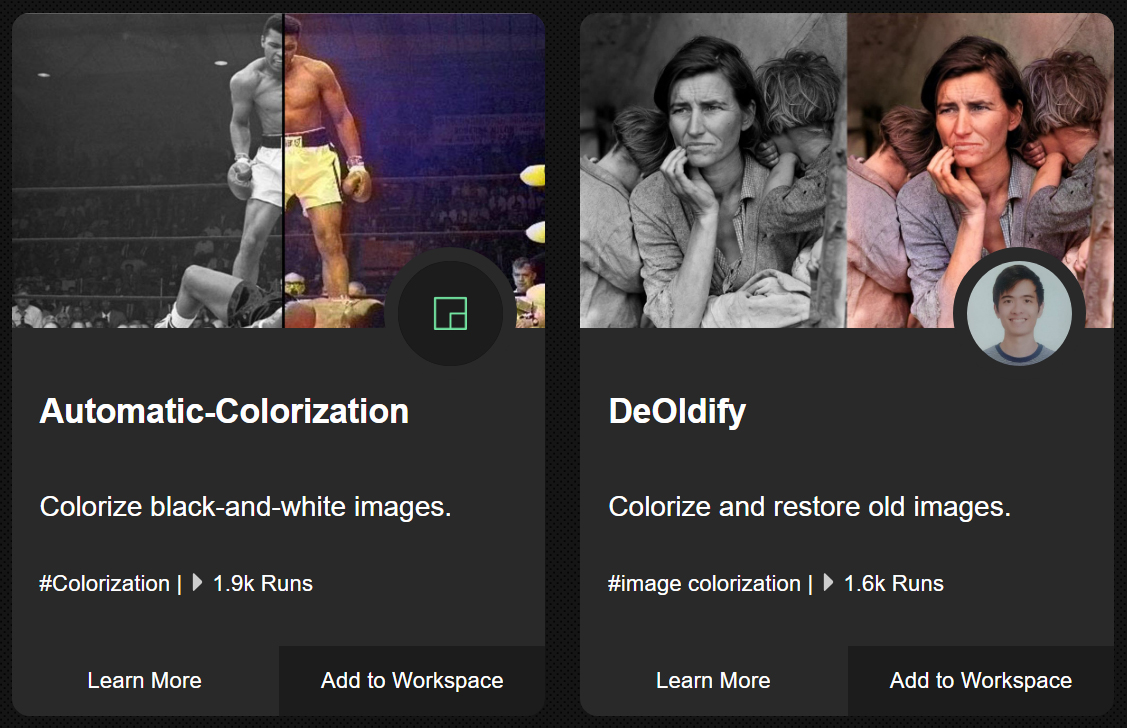

試しにモノクロ映像のカラー化をやってみよう。Models Directoryで”colorize”と検索してみると、Automatic ColorizationとDeOldifyの2つがヒットした↓

とりあえずDeOldifyの方を使ってみよう。Add to Workspaceでワークスペースに追加。

このモデルはクラウドGPUでのみ実行できるようだ。Artistic, Stable, Video,の3つのモデルが選べるらしいけど、とりあえずArtisticで。

InputとOutputの形式を指定して、Run Remotelyボタンを押すだけ。

オイラは手元にある初代ゴジラ (1954)の映像を使ってみた↓

昼間のシーンは割と上手くカラー化されたな。

まだベータ版だからなのか、Runway MLのインストール先ディレクトリを指定できなくて、Cドライブの変な場所を作業ディレクトリとして使われてしまうのが難アリな感じではある。

OutputのExport DirectoryをCドライブとは別のドライブに指定したらエラーで結果が保存されなかった。Export DirectoryにはCドライブ以下のディレクトリを指定しておかないと無駄なGPUクレジットを消費するはめになる。

InputとOutputに動画ファイルを指定することはできるけど、Output形式を動画にするとエンコードが粗くて低画質な動画が吐かれるので、Outputは連番静止画(Image Directory)にした方が無難。

そして、Input形式に動画ファイルを指定すると、Outputがコマ落ちしたりするので、ここも連番静止画の方が安全だ。

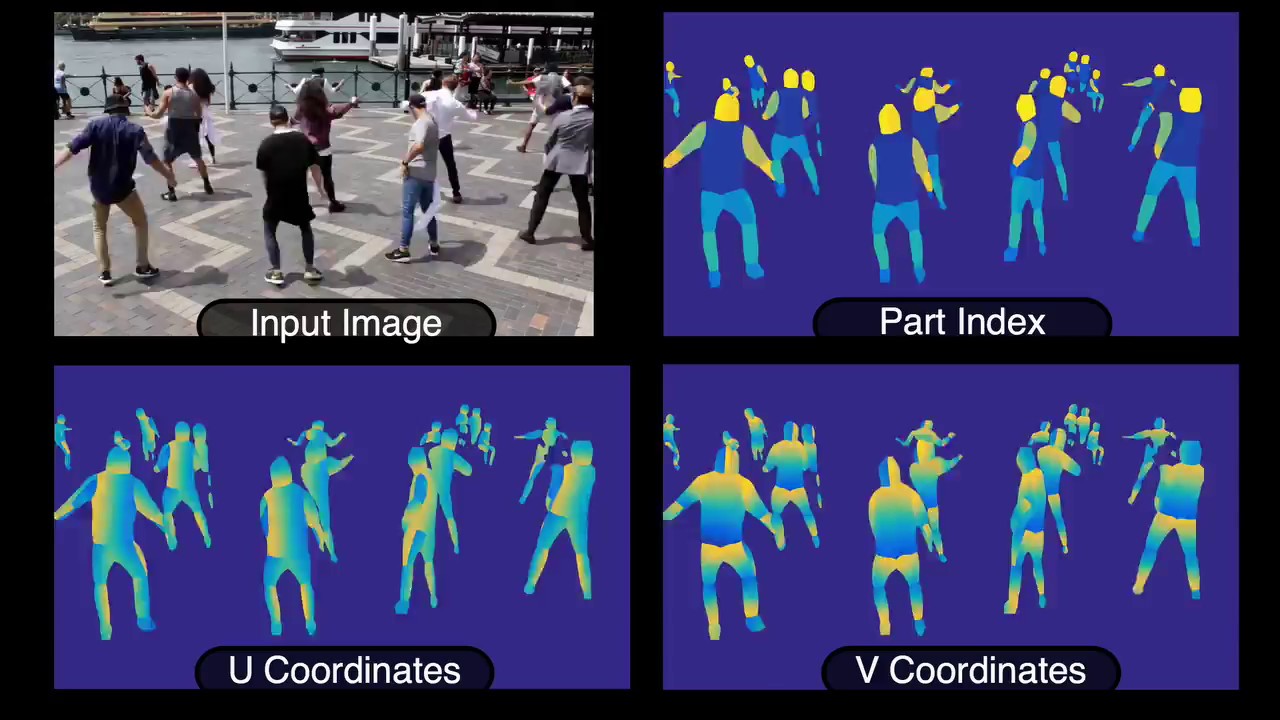

Runway MLには他にもモデルが沢山あり、DensePoseも手軽に試せそう。

最近のアップデートで複数のモデルを接続できるようになったらしい↓

https://medium.com/runwayml/adding-support-for-model-chaining-cd507f0fa935

関連記事

フルCGのウルトラマン!?

ワンダーフェスティバル2024[夏]に行ってきた

ポリゴン用各種イテレータと関数セット

NumSharp:C#で使えるNumPyライクな数値計算ライ...

9月15日(木)に全国26劇場で『シン・ゴジラ』一斉発声可能...

海洋堂 20cmシリーズ『84ゴジラ』 気泡の処理 その3

PyTorch3D:3Dコンピュータービジョンライブラリ

続・ディープラーニングの資料

ZBrushのお勉強

python-twitterで自分のお気に入りを取得する

2016年 観に行った映画振り返り

トランスフォーマーの変形パターンを覚えるのは楽しいと思うんだ

OpenCV 3.1のsfmモジュールを試す

Python2とPython3

ラクガキの立体化 反省

ラクガキの立体化 分割ラインの変更・バランス調整

Unity ARKitプラグインサンプルのドキュメントを読む

布地のシワの法則性

Raspberry PiでIoTごっこ

Ambient Occlusionを解析的に求める

ゴジラの音楽

『シン・ゴジラ』観ました (ネタバレ無し)

WebGL開発に関する情報が充実してきている

CGレンダラ研究開発のためのフレームワーク『Lightmet...

Windows Server 2008にAutodesk M...

mentalrayのSubsurface Scatterin...

Siggraph Asia 2009 カンファレンスの詳細

ポリゴンジオメトリ処理ライブラリ『pmp-library (...

スマホでカラーチューニングできるペンライト『KING BLA...

ワンダーフェスティバル2024[冬]に行ってきた

Russian3DScannerのトポロジー転送ツール『Wr...

アニゴジ関連情報

2D→3D復元技術で使われる用語まとめ

機械学習での「回帰」とは?

映画『ゴジラ キング・オブ・モンスターズ』を観てきた (ネタ...

海洋堂 20cmシリーズ『モスゴジ』 筆でレタッチ・全身のウ...

海洋堂 20cmシリーズ『84ゴジラ』 背びれ・下アゴパーツ...

写真に3Dオブジェクトを違和感無く合成する『3DPhotoM...

酒井ゆうじ造型工房『20cm ビオゴジ出現』 爪の塗装 やり...

ラクガキの立体化 背中の作り込み・手首の移植

物理ベースレンダリングのためのマテリアル設定チートシート

MFnDataとMFnAttribute

コメント