ついにFacebook Research公式から3Dディープラーニング用のPyTorchベースのライブラリが登場した。

ライセンスはBSD-3-Clauseライセンス。

PyTorch3D

PyTorch3Dは、PyTorchを使用した3Dコンピュータービジョン研究のための効率的で再利用可能なコンポーネントを提供します。

主要な機能は以下の通りです:

- 三角形Meshを保存・操作するためのデータ構造

- 三角形Mesh上での効率的な操作(射影変換、グラフ畳み込み、サンプリング、損失関数)

- 微分可能なMeshレンダラー

PyTorch3Dは3Dデータを予測・操作するためにディープラーニング手法とスムーズに統合できるよう設計されています。そのため、PyTorch3Dでの操作は全て以下に対応しています:

- PyTorchのtensorを使用した実装

- 異種データのミニバッチ処理

- 微分可能

- GPUによる処理の高速化

Facebook Research内では、PyTorch3DをMesh R-CNNなどの研究プロジェクトで使用しています。

ソースコードはGitHubにあり、ドキュメントはこちら。

INSTALL.mdを読むと、まだWindowsには対応していないみたいですね。

PyTorch3DまだWindows対応していないので、MacやLinux環境ないけどサクッと試したいだけの人はGoogleColabがおススメ。Notebookの先頭に以下でインスコすれば動きます。

!pip install 'git+https://t.co/8Cs3tKNij8'— Teppei Kurita (@kuritateppei) February 10, 2020

追記:Facebookの公式ブログの記事も公開された↓

https://ai.facebook.com/blog/-introducing-pytorch3d-an-open-source-library-for-3d-deep-learning/

We just released PyTorch3D, a new toolkit for researchers and engineers that’s fast and modular for 3D deep learning research: https://t.co/RmMSXJoWCm pic.twitter.com/H75Ai9gH2I

— Facebook AI (@facebookai) February 6, 2020

言及されているMesh R-CNNもソースコードが公開されている↓

https://github.com/facebookresearch/meshrcnn

https://ai.facebook.com/blog/pushing-state-of-the-art-in-3d-content-understanding/

個人的に興味があるのはDifferentiable Rendering周りのAPI↓

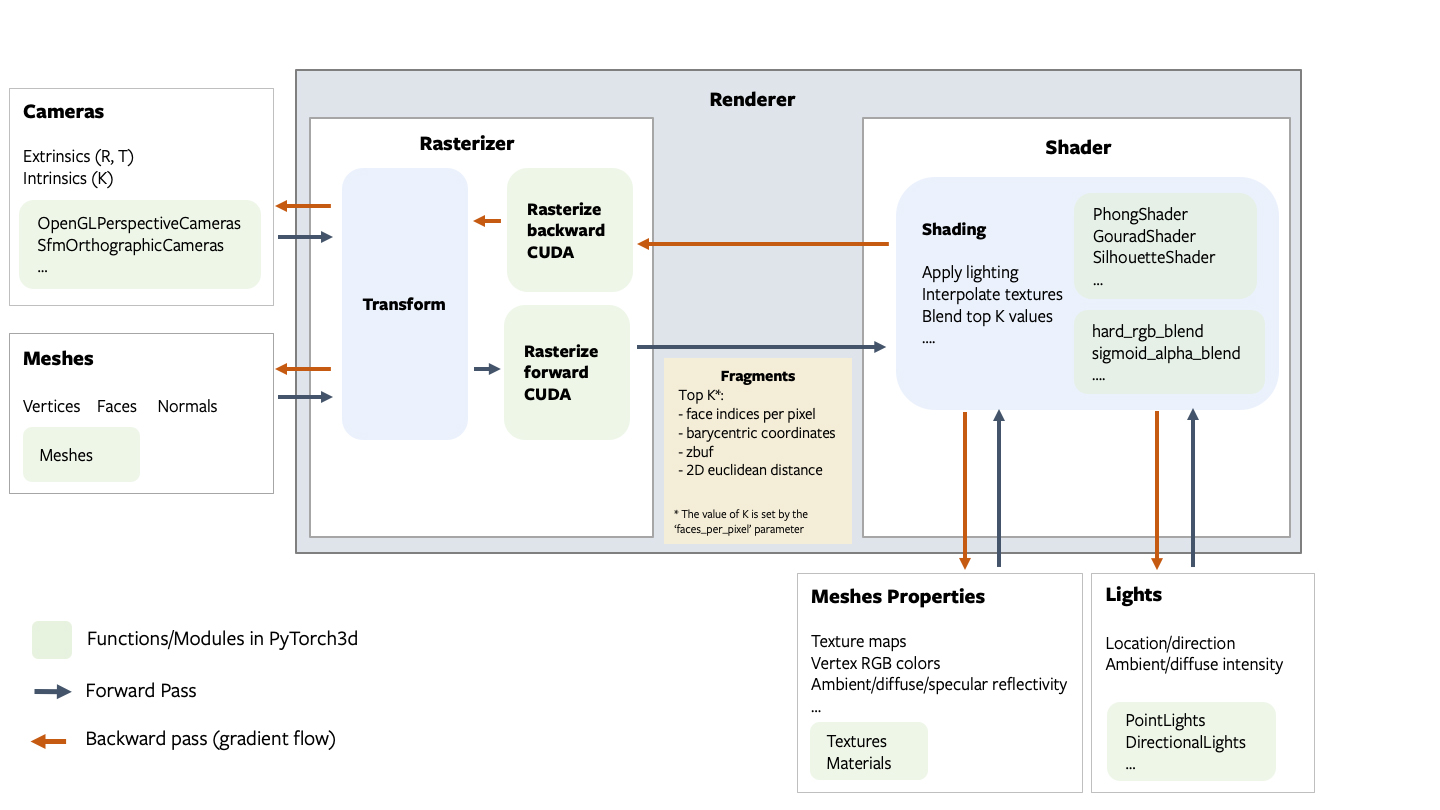

アーキテクチャの概要

レンダラーは、モジュール式で拡張可能に設計されており、全ての入力に対してバッチ処理、勾配(微分)をサポートしています。以下の図はレンダリングパイプラインの全てのコンポーネントを示しています。

Fragments

rasterizerは4つの出力tensorを以下のような名前付きtupleで返します。

pix_to_face:(N, image_size, image_size, faces_per_pixel)形状のlong型tensor。画像の各ピクセルに重なるfaceのインデックスを(packed faceで)指定します。zbuf:(N, image_size, image_size, faces_per_pixel)形状のfloat型tensor。各ピクセルで最も近いfaceのworld座標系でのz座標をz値の昇順で提供します。bary_coords:(N, image_size, image_size, faces_per_pixel, 3)形状のfloat型tensor。各ピクセルで最も近いfaceの重心座標をNDC単位でz値の昇順で提供します。pix_dists:(N, image_size, image_size, faces_per_pixel)形状のflaot型tensor。ピクセルに最も近い各点のx/y平面での符号付きユークリッド距離(NDC単位)を提供します。パイプラインの各コンポーネントの詳細については、レンダラーAPIリファレンスを参照してください。

注意:differentiable renderer APIは試験的なものであり、仕様は今後変更される可能性があります。

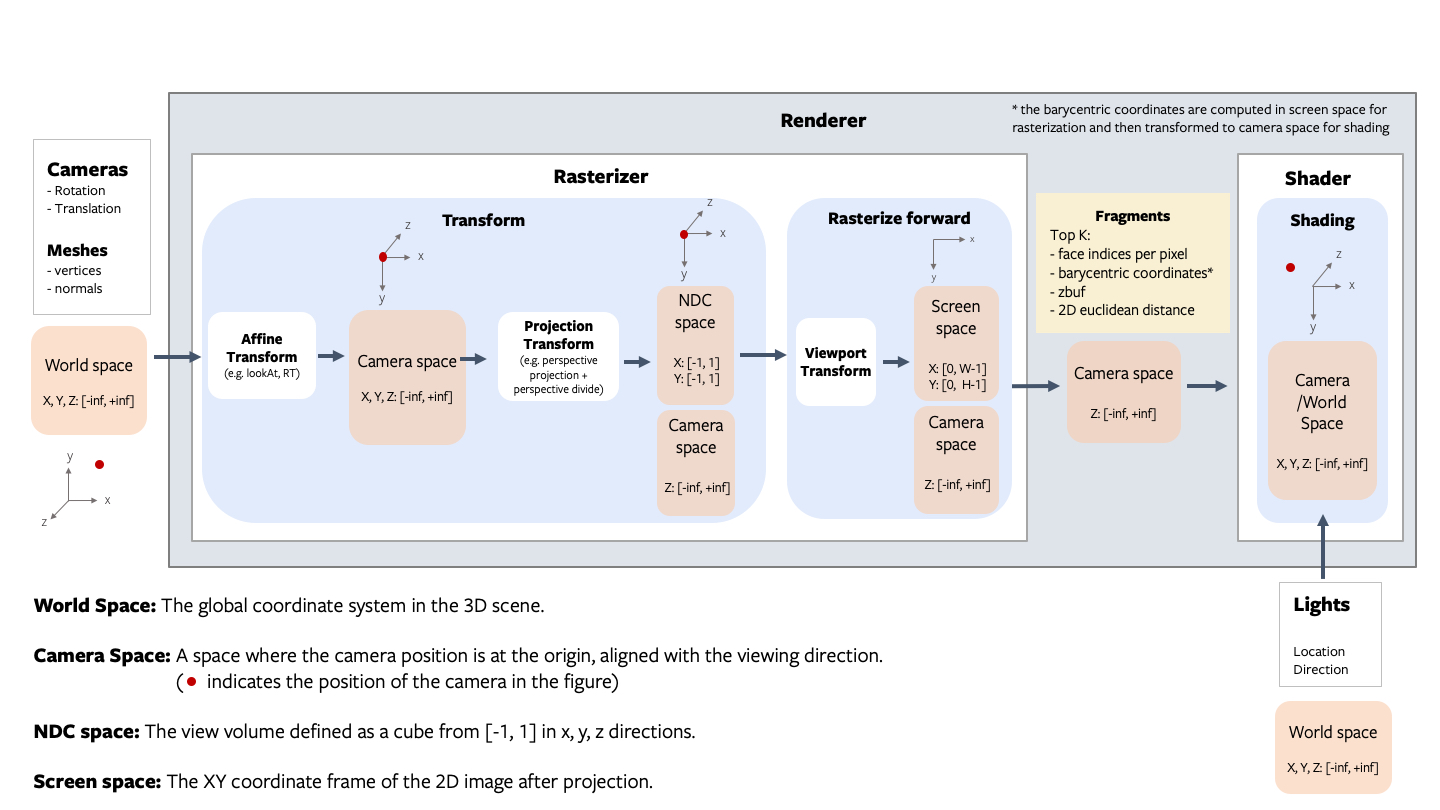

座標変換の規則

レンダリングでは、座標空間を異なる座標空間へ変換する処理を何度か行う必要があります:world空間、view/camera空間、NDC空間、screen空間があります。これら各座標空間でカメラがどこに位置しているか、x, y, z軸がどのような配置関係でどのような範囲の値を取るのかを知ることが重要です。以下の図は、PyTorch3dが使用する規則を示しています。

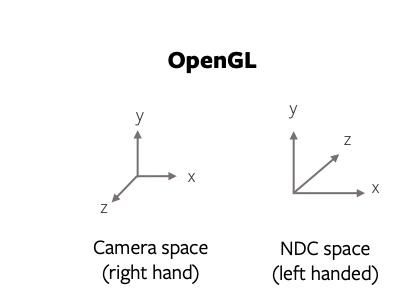

注意:PyTorch3d vs OpenGL

PyTorch3dはOpenGLに似せるようにしていますが、OpenGLの左手系のNDC座標系と違い、PyTorch3dのNDC座標系は右手系となっています。(射影行列によって利き手が切り替わります)

OpenGLでは、camera空間の原点にあるカメラが奥行きをz軸マイナス方向に捉えるのに対し、PyTorch3dではNDC空間のz軸プラス方向に奥行きを捉えます。

シンプルなレンダラー

PyTorch3dのレンダラーはrasterizerとshaderで構成されています。レンダラーを作成するには以下のように記述します。

# Imports from pytorch3d.renderer import ( OpenGLPerspectiveCameras, look_at_view_transform, RasterizationSettings, BlendParams, MeshRenderer, MeshRasterizer, PhongShader ) # Initialize an OpenGL perspective camera. R, T = look_at_view_transform(2.7, 10, 20) cameras = OpenGLPerspectiveCameras(device=device, R=R, T=T) # Define the settings for rasterization and shading. Here we set the output image to be of size # 512x512. As we are rendering images for visualization purposes only we will set faces_per_pixel=1 # and blur_radius=0.0. Refer to rasterize_meshes.py for explanations of these parameters. raster_settings = RasterizationSettings( image_size=512, blur_radius=0.0, faces_per_pixel=1, bin_size=0 ) # Create a phong renderer by composing a rasterizer and a shader. Here we can use a predefined # PhongShader, passing in the device on which to initialize the default parameters renderer = MeshRenderer( rasterizer=MeshRasterizer(cameras=cameras, raster_settings=raster_settings), shader=PhongShader(device=device, cameras=cameras) )

NDCって何のことかと思ったらNormalized Device Coordinates(正規化デバイス座標系)のことか。

https://qiita.com/T_keigo_wwk/items/d8b8686480b061c453d9

https://note.com/npaka/n/nc8db869964f2

Google Colabで試すのが近道かな。

https://medium.com/analytics-vidhya/get-started-with-pytorch3d-in-4-minutes-with-google-colab-16d40968053e

なんだか急激に3Dディープラーニングが当たり前の時代が来てしまった感。

さっさとBlenderとつないで遊びたい。

関連記事

映画『ブレードランナー 2049』のVFX

ファンの力

Model View Controller

C++ 標準テンプレートライブラリ (STL)

html5のcanvasの可能性

プログラミングスキルとは何か?

ZBrushでアヴァン・ガメラを作ってみる 全体のバランス調...

ZBrushでゴジラ2001を作ってみる 頭の概形作り

Geogram:C++の3D幾何アルゴリズムライブラリ

書籍『イラストで学ぶ ディープラーニング』

ZBrushで仮面ライダー3号を造る 仮面編 PolyGro...

マルコフ連鎖モンテカルロ法

映画『ゴジラ-1.0』 メイキング情報まとめ

オープンソースのロボットアプリケーションフレームワーク『RO...

ラクガキの立体化 背中の作り込み・手首の移植

Kubric:機械学習用アノテーション付き動画生成パイプライ...

iOSで使えるJetpac社の物体認識SDK『DeepBel...

ニューラルネットワークと深層学習

ZBrush 2021.6のMesh from Mask機能...

Theia:オープンソースのStructure from M...

日立のフルパララックス立体ディスプレイ

OpenCVの顔検出過程を可視化した動画

Maya API Reference

ZBrushでアヴァン・ガメラを作ってみる 全体のバランス調...

Physics Forests:機械学習で流体シミュレーショ...

Unityからkonashiをコントロールする

手を動かしながら学ぶデータマイニング

Human Generator:Blenderの人体生成アド...

ラクガキの立体化 胴体の追加

株式会社ヘキサドライブの研究室ページ

Kinect for Windows v2の日本価格決定

TensorFlowでCGを微分できる『TensorFlow...

SIGGRAPH ASIAのマスコット

HerokuでMEAN stack

Unityで強化学習できる『Unity ML-Agents』

フリーのUV展開ツール Roadkill UV Tool

Deep Learningとその他の機械学習手法の性能比較

HD画質の無駄遣い その2

ポイントクラウドコンソーシアム

スターウォーズ エピソードVIIの予告編

Pythonの自然言語処理ライブラリ『NLTK(Natura...

3D Gaussian Splatting:リアルタイム描画...

コメント