オープンソースのグローバルイルミネーションレンダラのMitsuba↓

Mitsuba – physically based renderer

Mitsubaは、PBRTのスタイルに則った研究指向のレンダリングシステムで、多くのインスピレーションを得ています。

Mitsubaは移植性の高いC++で記述されており、偏りのない手法と偏りのない手法を実装し、現在のCPUアーキテクチャを対象とした高度な最適化が含まれています。

Mitsubaは非常にモジュール式です:コアライブラリの小さなセットと、マテリアルや光源から完全なレンダリングアルゴリズムに至るまでの機能を実装する100種類を超えるプラグインで構成されています。

他のオープンソースレンダラーと比較して、MitsubaはMetropolis Light Transportのパスベースの定式化やボリュメトリックモデリングアプローチなどの実験的レンダリング技術に重点を置いています。

そのため、まだ主流のレンダラーへの道を見つけていないようなテクニックを試してみたい人にとっては本当に興味があるかもしれませんし、この領域での研究のための強固な基盤も提供します。

このレンダラーは現在Linux, MacOS X, Microsoft Windowsに対応し、x86, x86_64プラットフォームでのSSE2最適化を利用しています。

これまでのところ、その主な用途はコンピューターグラフィックスのアルゴリズム開発のテストベッドとしてでしたが、他にも多くの興味深いアプリケーションがあります。

Mitsubaには、シーンをインタラクティブに探索するためのコマンドラインインターフェイスとグラフィカルフロントエンドが付属しています。

ナビゲート中、大まかなプレビューが表示され、すべての動きが停止するとすぐに精度が向上します。

視点が選択されると、幅広いレンダリング技術を使用して画像を生成し、それらのパラメーターをプログラム内から調整できます。

ソースコードはGitHubにある↓

https://github.com/mitsuba-renderer/mitsuba

いつか試そうと思ってだいぶ時間が経ってしまったんだけど、MitsubaにはMayaと連携するためのプラグインもあるので試してみた。

https://github.com/mitsuba-renderer/mitsuba

ところが、このプラグイン、想像してたのと違って、あんまり連携感がない。Maya上のオブジェクトを描画できるわけだけど、もろもろの設定はMayaのGUIではなく、結局xmlの設定ファイルを直接いじるタイプだった。(MayaのGUI上でxmlを編集するエディタが立ち上がる。)

そんで、もうちょっと調べてみたら、有志(?)でMitsubaをPythonでラップしてプラグインっぽくした人がいた。→Installing MitsubaForMaya

プラグインコード(Python)とサンプルプロジェクトがGitHubに上がっている。→MitsubaForMaya

で、やってみた。このプラグインは外部のMitsubaのexeを呼び出す操作をラップしてMayaのGUI操作ライクにしてくれてるんだけど、コードの中に絶対パスを書いていて、エラーまみれになった。GUIはよくできてたんだけどね。もうちょっと中身読めば修正できそうな気もする。

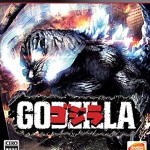

で、いったんMayaで動かすのはあきらめて、MitsubaのスタンドアローンのGUIアプリを実行してみた。レンダリングするシーンファイルのサンプルが公式のダウンロードページに置いてある。試したのは毛糸のマフラーみたいなやつ。Siggraph2010で発表されたこの論文のデータね。

まるで実写みたい。

Pythonのインターフェイスがあるみたいだから、上手く使えばAPIっぽく自前のプログラムから使えると思うんだけど、なかなかサンプルが見当たらない。

http://rgl.epfl.ch/publications/NimierDavidVicini2019Mitsuba2

2019年 追記:Siggraph Asia 2019でMitsuba 2が発表された↓

コメント