数度のトライを経て、OpenCVのバージョン3.3.0でやっとsfmモジュールのビルドが通ったわけです。

ようやくサンプルを試す段階に来た。参考にしてるQiita記事の後編へやっと進める。↓

http://qiita.com/ChaoticActivity/items/178d23508b92a09e59ea

記事によると、サンプルを動かすためにまたいくつか手を加える必要がある(笑)

ヘッダーファイルの修正

さて、opencv_contrib-3.3.0/modules/sfm/samples以下にあるsfmのサンプルをそのままビルドしようとすると

reconstruct()が定義されていません

的なエラーが出る。

このエラーの理由は、いくつかのヘッダーファイルで

#if CERES_FOUND

という条件マクロが書かれており、Ceres-Solverの有無でincludeするファイルを選択しているから。なので、この条件がtrueになるようにコンパイラにCeres-Solverが存在することを知らせる必要がある。

で、ちょっと行儀が悪いけど、オイラはもうinclude/opencv2/sfm.hppの冒頭の以下の記述を

#ifndef __OPENCV_SFM_HPP__ #define __OPENCV_SFM_HPP__ #include <opencv2/sfm/conditioning.hpp> #include <opencv2/sfm/fundamental.hpp> #include <opencv2/sfm/numeric.hpp> #include <opencv2/sfm/projection.hpp> #include <opencv2/sfm/triangulation.hpp> #if CERES_FOUND #include <opencv2/sfm/reconstruct.hpp> #include <opencv2/sfm/simple_pipeline.hpp> #endif

直接以下のように編集しちゃいました。

#ifndef __OPENCV_SFM_HPP__ #define __OPENCV_SFM_HPP__ #include#include #include #include #include #include #define CERES_FOUND 1 #if CERES_FOUND #include #include #endif

サンプルコードの実行

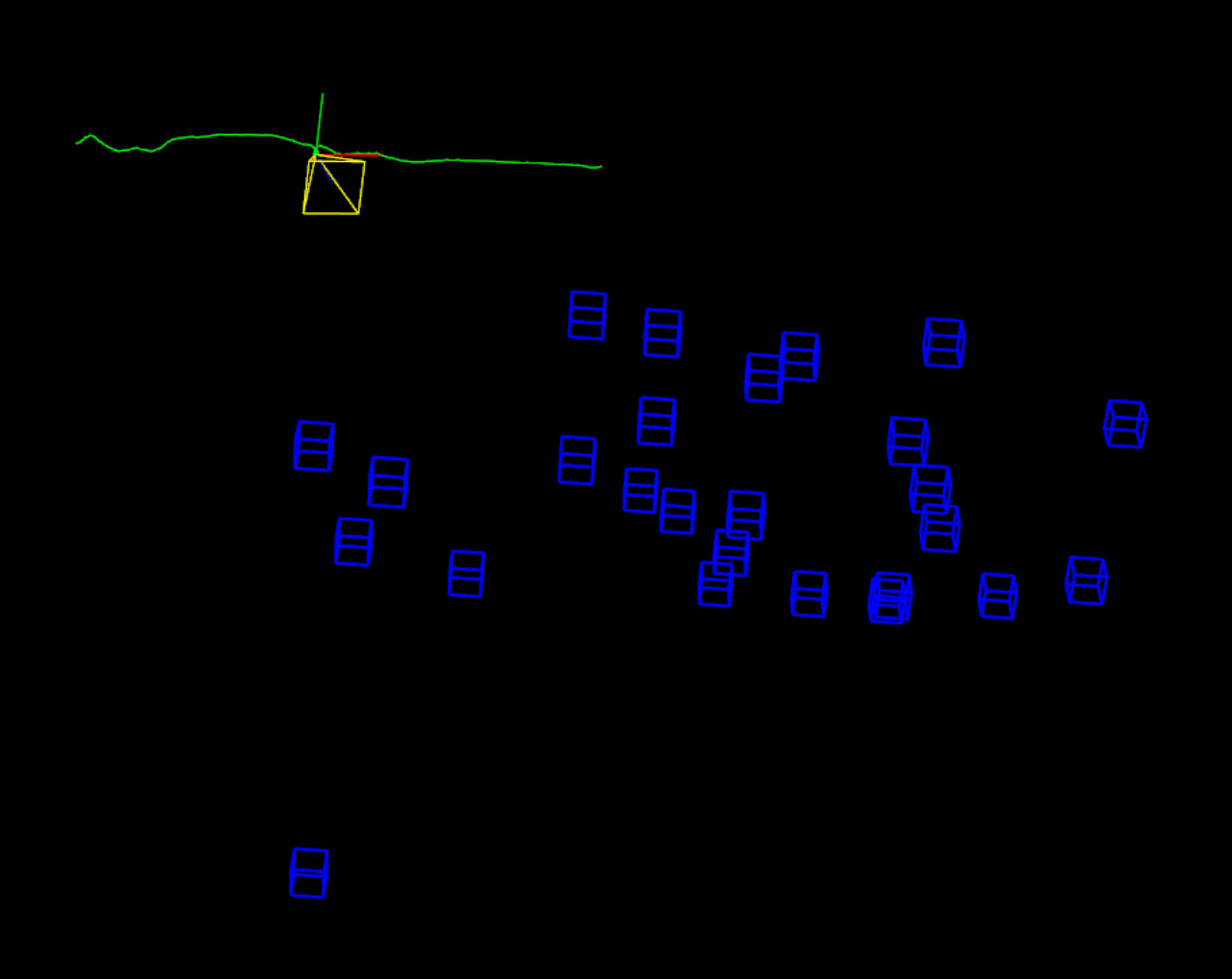

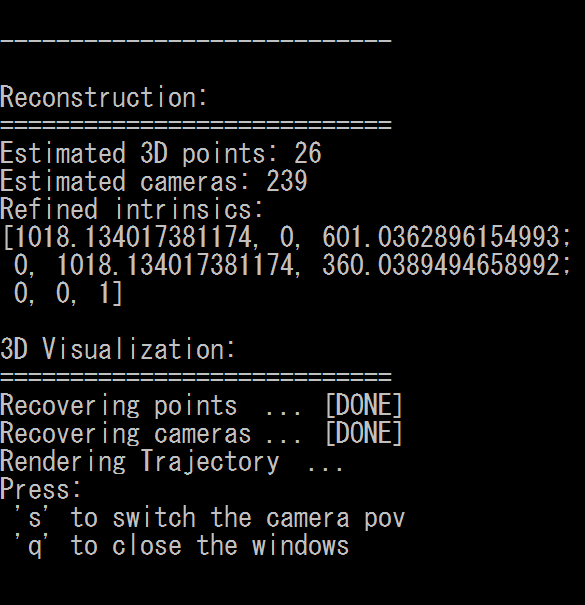

参考記事に倣ってtrajectory_reconstruccion.cppを実行してみる。

おお、特にエラーも無く動作したぞ!

サンプルコードのバグ修正

参考記事によると、このサンプルコードにはバグがあるというか、カメラの軌跡を表示する際に使用しているcv::viz::WTrajectoryに渡す引数が間違っているらしい。

以下の部分を

/// Recovering cameras

cout << "Recovering cameras ... ";

vector<Affine3d> path_est;

for (size_t i = 0; i < Rs_est.size(); ++i)

path_est.push_back(Affine3d(Rs_est[i],ts_est[i]));

cout << "[DONE]" << endl;

逆行列に変えて以下のようにすると正しい座標変換になる。

/// Recovering cameras

cout << "Recovering cameras ... ";

vector<Affine3d> path_est;

for (size_t i = 0; i < Rs_est.size(); ++i)

path_est.push_back(Affine3d(Rs_est[i], ts_est[i]).inv());

cout << "[DONE]" << endl;

別のサンプルコード

調子に乗ってscene_reconstruction.cppも動かしてみようと思ったら見事エラー…

http://docs.opencv.org/3.3.0/d4/d18/tutorial_sfm_scene_reconstruction.html

え、正しいコマンドライン引数が良く分からんぞ。。。

関連記事

ブログが1日ダウンしてました

Maya API Reference

SSII2014 チュートリアル講演会の資料

UnityのGameObjectの向きをScriptで制御す...

ZBrushでカスタムUIを設定する

FreeMoCap Project:オープンソースのマーカー...

NeRF (Neural Radiance Fields):...

PythonのHTML・XMLパーサー『BeautifulS...

OpenSfM:PythonのStructure from ...

SDカードサイズのコンピューター『Intel Edison』

Deep Fluids:流体シミュレーションをディープラーニ...

PGGAN:段階的に解像度を上げて学習を進めるGAN

オープンソースのロボットアプリケーションフレームワーク『RO...

Raspberry PiでIoTごっこ

WordPressの表示を高速化する

スクラッチで既存のキャラクターを立体化したい

KelpNet:C#で使える可読性重視のディープラーニングラ...

WordPressプラグインによるサイトマップの自動生成

NumSharp:C#で使えるNumPyライクな数値計算ライ...

まだ続くブログの不調

Raspberry PiのGPIOを操作するPythonライ...

自前Shaderの件 解決しました

AmazonEC2のインスタンスをt1.microからt2....

OpenCVでiPhone6sのカメラをキャリブレーションす...

Kaolin:3Dディープラーニング用のPyTorchライブ...

顔画像処理技術の過去の研究

TorchStudio:PyTorchのための統合開発環境と...

機械学習に役立つPythonライブラリ一覧

Quartus II

第25回コンピュータビジョン勉強会@関東に行って来た

Unity MonoBehaviourクラスのオーバーライド...

JavaScriptとかWebGLとかCanvasとか

MythTV:Linuxでテレビの視聴・録画ができるオープン...

Geogram:C++の3D幾何アルゴリズムライブラリ

Twitter APIのPythonラッパー『python-...

Python for Unity:UnityEditorでP...

Unityの各コンポーネント間でのやり取り

OpenCV 3.1のsfmモジュールのビルド再び

Alice Vision:オープンソースのPhotogram...

C#で使える遺伝的アルゴリズムライブラリ『GeneticSh...

Mitsuba 3:オープンソースの研究向けレンダラ

SSII 2014 デモンストレーションセッションのダイジェ...

コメント