この前見つけたOpenMVSをビルドしてみようと思ってドキュメント見たら、すでにサンプルをWindows用にビルドしたバイナリが配布されているではないか!

公式ドキュメントのUsageページの内容も、配布されているopenMVS_sampleを使えばできそうな感じ。

ただ、ドキュメントがやや古いのか、書いてある実行ファイルの名称が配布されているものとちょっと食い違っているみたい。

たぶん、ドキュメントで”openMVG_main_openMVG2openMVS“って書かれているのは、現在のサンプルの中にある”InterfaceOpenMVG“のこと。ソースコードのInterfaceOpenMVG.cppの中身をちょっと見てみると、ドキュメント記載の”openMVG_main_openMVG2openMVS“と同じ引数を受け取りそうな感じ。

openMVGでSFMデータ(sfm_data.bin)を作成する

とりあえず、OpenMVSに食わせるためのsfm_data.binをopenMVGでちゃちゃっと生成してしまう。この前ビルドしたopenMVGのSfM toolsを使う。

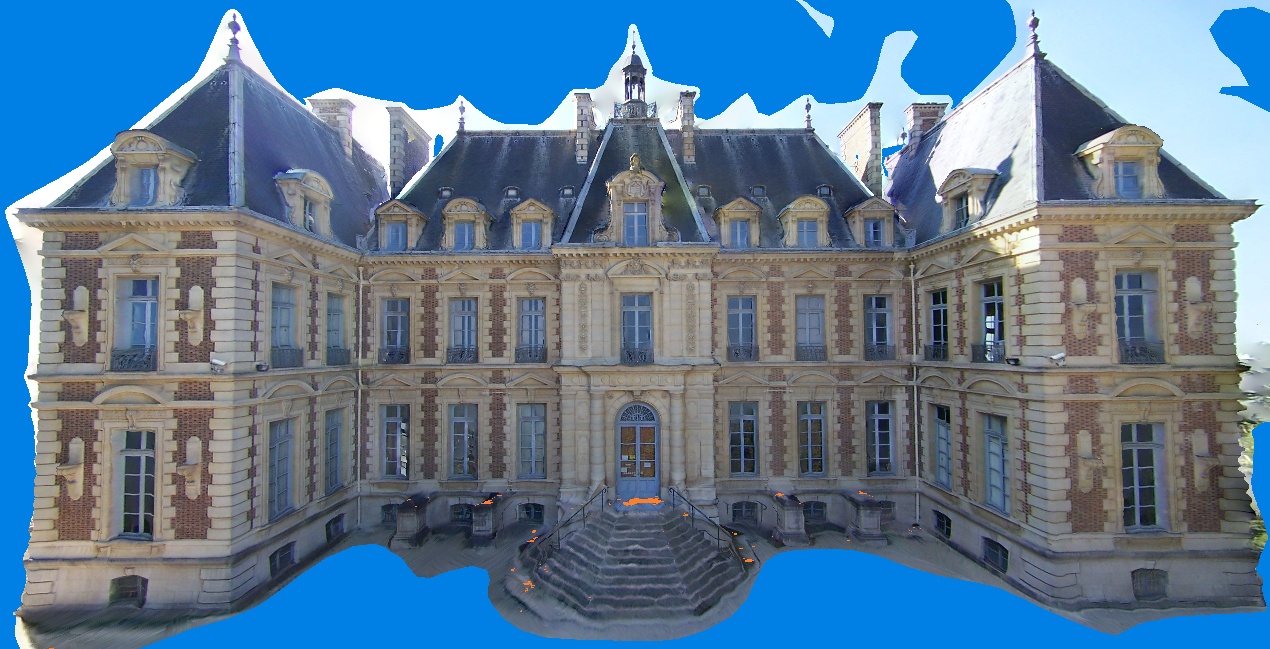

OpenMVSの使い方の例に合わせてSceaux Castleの画像セットを使用する。

Sceaux Castle画像セットを入力として以下のツールを順に実行すると、最終的にsfm_data.binが出力される。コマンドライン引数はそれぞれのドキュメント参照。

- openMVG_main_SfMInit_ImageListing:画像リストの作成

- openMVG_main_ComputeFeatures:画像特徴の検出・記述

- openMVG_main_ComputeMatches:画像の対応関係の計算

- openMVG_main_IncrementalSfM:3次元再構築(Structure from Motion)

sfm_data.binと一緒にいくつか.plyファイルも出力される。この.plyファイルをMeshLabで開けば3次元再構築の結果を確認できる。

で、出力されたsfm_data.binを使ってOpenMVSのMulti-View Stereoによる密な点群の復元を試すわけだけど、まずは現在配布されているOpenMVSの最新のサンプルの構成に合わせて、やや古いOpenMVS公式のドキュメントの記述を読み換えながら訳してみる。

OpenMVSモジュールの使い方

次は、利用可能なモジュールの使い方の説明です。

今回は、OpenMVGのパイプラインを使い、Sceaux Castle画像セットからカメラ位置と疎な点群の復元を行いました。

ここで示すアウトプットは、全てOpenMVSのパイプラインで自動的に生成したものであり、手作業による調整は一切行っていない結果であることに注意してください。

完全なサンプル(モジュール用のWindows x64バイナリを含む)はOpenMVS_Sampleにあります。

OpenMVSのバイナリは、全てコマンドライン引数をサポートしています。引数の詳細については、引数無し、または-hコマンドで実行すると表示されます。

@FlachyJoe氏がOpenMVGとOpenMVSの連携プロセスを自動化した、コマンド1つで実行できるscriptを提供しています。

以下のコマンドを実行すれば同様の結果が得られるはずです:

python MvgMvs_Pipeline.py

OpenMVGのシーンを変換する

シーンの再構築後、OpenMVGはデフォルトでカメラ位置と疎な点群情報の入った

sfm_data.binファイルを生成します。

エクスポーターツールを以下コマンドで実行すれば、このファイルをOpenMVSのプロジェクトファイルscene.mvsへ変換できます。

InterfaceOpenMVG -i sfm_data.bin -o scene.mvs

OpenMVGが古い.jsonアスキー形式のファイルを使っている場合は、以下のように実行してください。

InterfaceOpenMVG -i scene.json -o scene.mvs

ここまでのステップで得られた疎な点群は以下の画像のようになるはずです:

密な点群の再構築(オプション)

シーンに欠けている部分があっても、dense reconstruction(密な再構築)モジュールを使って密な点群を推定すれば復元することができます。

DensifyPointCloud scene.mvs

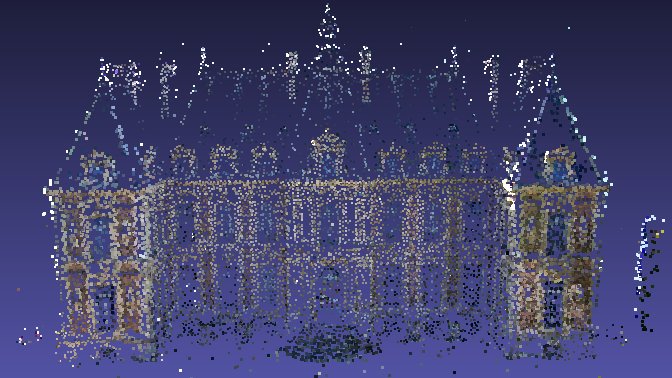

得られた高密度の点群は以下の画像のようになります(頂点の色は可視化のためのおおよそのものであり、以降の処理には影響しないことに注意):

ラフなメッシュの再構築

ここまでのステップで得られた疎、密な点群をmesh reconstruction(メッシュの再構築)モジュールの入力として使うことができます。

ReconstructMesh scene_dense.mvs

mesh reconstructionモジュールを実行して得られるメッシュ:

メッシュのリファイン(オプション)

疎、密な点群から得られたメッシュには、まだディティールや大きな欠落部分をリファインできる余地があります。

以下のコマンドで、疎な点群から得たラフなメッシュのリファインを行ってみます:

RefineMesh scene_mesh.mvs

リファイン前と後:

メッシュにテクスチャを貼る

ここまでのステップで得られたメッシュをmesh texturing(メッシュにテクスチャを貼る)モジュールの入力として使います。

TextureMesh scene_dense_mesh.mvs

メッシュにテクスチャを貼った状態:

“openMVG_main_openMVG2openMVS“を”InterfaceOpenMVG“と読み替えるだけでちゃんと動いたぞ。さらにOopenMVS_sampleにはopenMVGだけでなく、VisualSFMのファイルを変換するInterfaceVisualSFMも入っているので、VisualSFMで疎な点群の復元まで終えたデータからOpenMVSで密な点群の復元ができるわけだな。

まあ、もちろんPMVSやCMVSとかCMPMVSでも良いんですが。

関連記事

OpenGV:画像からカメラの3次元位置・姿勢を推定するライ...

ZScript

なんかすごいサイト

統計的な顔モデル

書籍『3次元コンピュータビジョン計算ハンドブック』を購入

GeoGebra:無料で使える数学アプリ

CNN Explainer:畳み込みニューラルネットワーク可...

顔追跡による擬似3D表示『Dynamic Perspecti...

UnityからROSを利用できる『ROS#』

Regard3D:オープンソースのStructure fro...

OpenVDB:3Dボリュームデータ処理ライブラリ

DensePose:画像中の人物表面のUV座標を推定する

OpenCV 3.1のsfmモジュールのビルド再び

U-Net:ディープラーニングによるSemantic Seg...

NumSharp:C#で使えるNumPyライクな数値計算ライ...

Unity Scriptコーディング→Unreal Engi...

CGレンダラ研究開発のためのフレームワーク『Lightmet...

3D Gaussian Splatting:リアルタイム描画...

CGのためのディープラーニング

Blender 4.2以降のWindowsPortable版...

AR (Augmented Reality)とDR (Dim...

網元AMIで作ったWordpressサイトのインスタンスをt...

Digital Emily Project:人間の顔をそっく...

書籍『ゼロから作るDeep Learning』で自分なりに学...

OpenAR:OpenCVベースのマーカーARライブラリ

HD画質の無駄遣い その2

Pythonの自然言語処理ライブラリ『NLTK(Natura...

TeleSculptor:空撮動画からPhotogramme...

R-CNN (Regions with CNN featur...

Pylearn2:ディープラーニングに対応したPythonの...

AndroidもopenGLも初心者さ (でもJavaは知っ...

Unity ARKitプラグインサンプルのドキュメントを読む

GoogleのDeep Learning論文

Facebookの顔認証技術『DeepFace』

OpenCVのfindEssentialMat関数を使ったサ...

UnityでPoint Cloudを表示する方法

2D→3D復元技術で使われる用語まとめ

PyTorch3D:3Dコンピュータービジョンライブラリ

Google App Engine上のWordPressでA...

AnacondaとTensorFlowをインストールしてVi...

openMVGをWindows10 Visual Studi...

Google Chromecast

コメント