だいぶ時間が空きましたが、引き続きOpenCVの3次元復元系の関数を見ていく。

OpenCVのfindEssentialMat関数を使ったサンプルを読んでみる本来なら例の書籍を読み進めて少しずつ理解していくつもりだったけど、しんどい。。。書籍はなかなか読み進められなかったので、飛ばし読みしてプログラムを動かしながら徐々にディティールを理解していく方針へ切り替えた(笑)何度か格闘するも上手くいかな...

OpenCVのfindEssentialMat関数を使ったサンプルを読んでみる本来なら例の書籍を読み進めて少しずつ理解していくつもりだったけど、しんどい。。。書籍はなかなか読み進められなかったので、飛ばし読みしてプログラムを動かしながら徐々にディティールを理解していく方針へ切り替えた(笑)何度か格闘するも上手くいかな...

今回はcalib3dモジュールにあるtriangulatePoints関数。つまり三角測量を行う関数ですね。

void cv::triangulatePoints(InputArray projMatr1,

InputArray projMatr2,

InputArray projPoints1,

InputArray projPoints2,

OutputArray points4D

)

三角測量で点を再構築します。

パラメータ

- projMatr1 1つ目のカメラの射影行列(3×4)

- projMatr2 2つ目のカメラの射影行列(3×4)

- projPoints1 1枚目の画像中の特徴点の配列(2xN)

- projPoints2 2枚目の画像中の1枚目に対応する特徴点の配列(2xN)

- points4D 同次座標における再構成後の点の配列(4×N)

この関数は、ステレオカメラによる観測によって(同次座標での)3次元点を再構築します。投影行列はstereoRectify関数で得ることができます。

注意

この関数を使うには、すべての入力データがfloat型である必要があります。

http://docs.opencv.org/3.2.0/d9/d0c/group__calib3d.html#gad3fc9a0c82b08df034234979960b778c

具体的な使い方を見て行こう。こちらのブログ記事に載っているコードを参考に書いてみた↓

http://moitkfm.blogspot.jp/2014/06/2.html

使う2枚の画像は、以前撮影したスターデストロイヤーのターンテーブル動画から1フレーム目と50フレーム目を抜粋して使用する。

撮影に使ったiPhone6sのカメラキャリブレーションデータもあるし。

OpenCVでiPhone6sのカメラをキャリブレーションする

世間ではiPhone7が発売されていますが、オイラは引き続きiPhone6sを使います(笑)1年前にiPhone6Sへ機種変更してからiPhone6sのカメラで結構たくさん写真や動画を撮ったので、画像・動画がだいぶ溜まった。それらの画像・動...

以下がソースコード。AKAZE特徴で2枚の画像の対応点を求めることにした。

結果の可視化にvizモジュールを使っているので、vizも含めてビルド済みのOpenCV3.3.0-rcを使用。

AKAZE特徴のマッチング結果はこちら↓

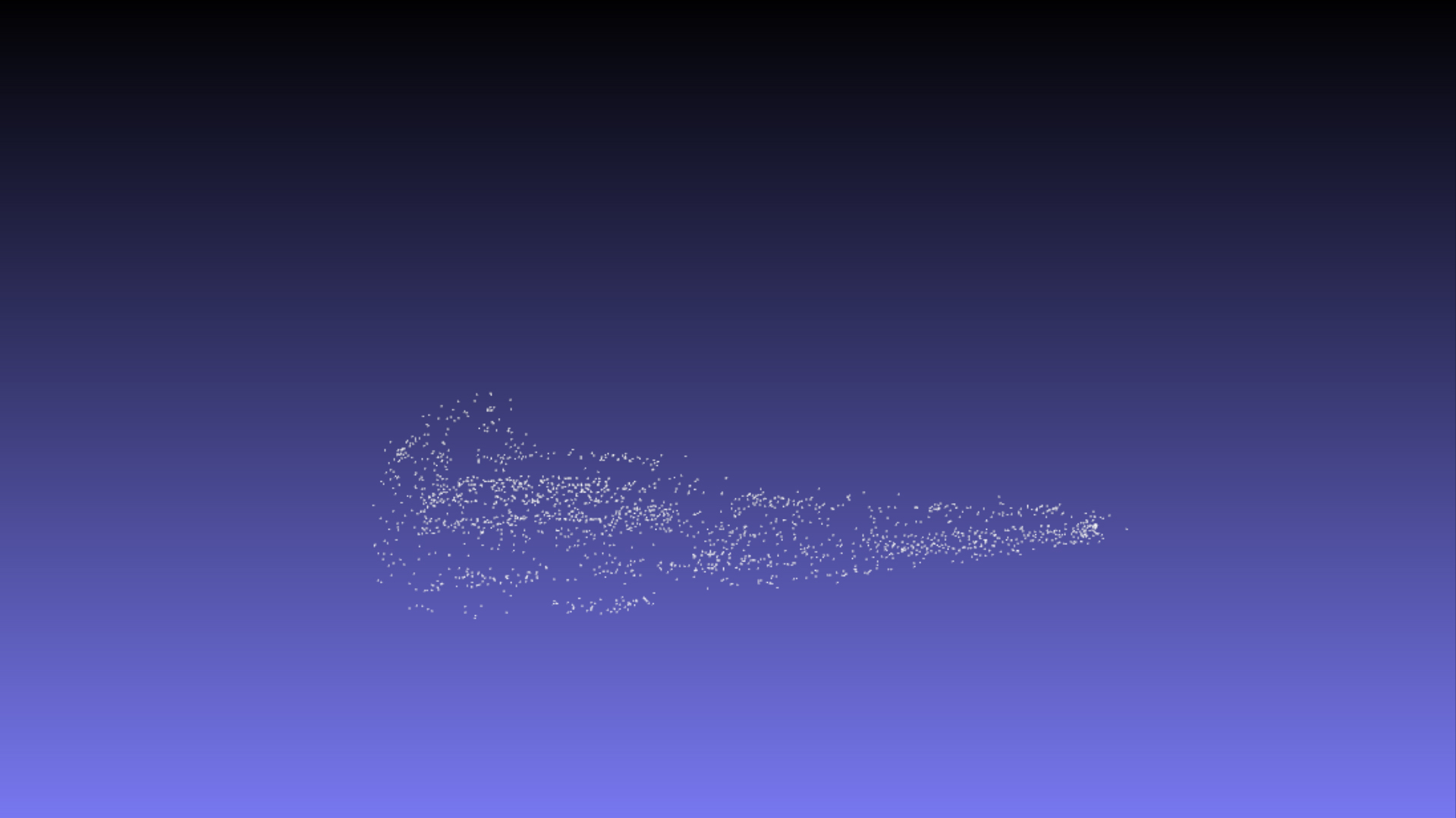

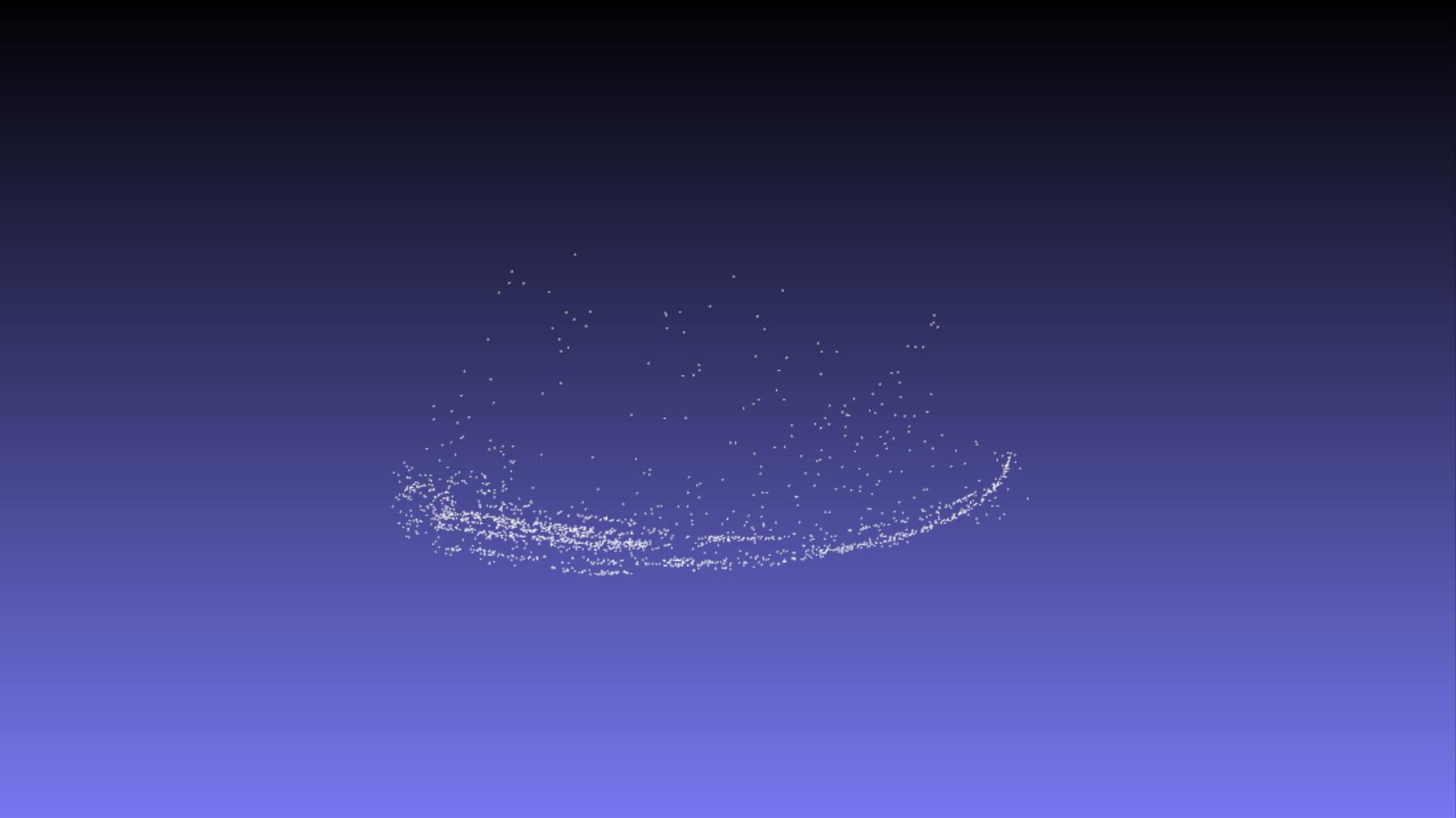

で、三角測量の結果をvizモジュールで可視化したものがこちら↓

側面は何となくそれっぽいぞ。と思って上から見てみたら、なんだか湾曲している。。。

レンズっぽい球面な歪み方だな。

あ、以前作った連番はすでにレンズの歪み補正を終えているから、補正処理は必要無いのか。

追記:よくよく考えたら、関数の出力は同次座標だからそのまま3次元ベクトルに代入して表示しちゃダメだな。

コメント