ポリ男をリファインしたので

ポリ男のMeshからこのチュートリアル動画に従ってMetaHumanを作成してみよう↓

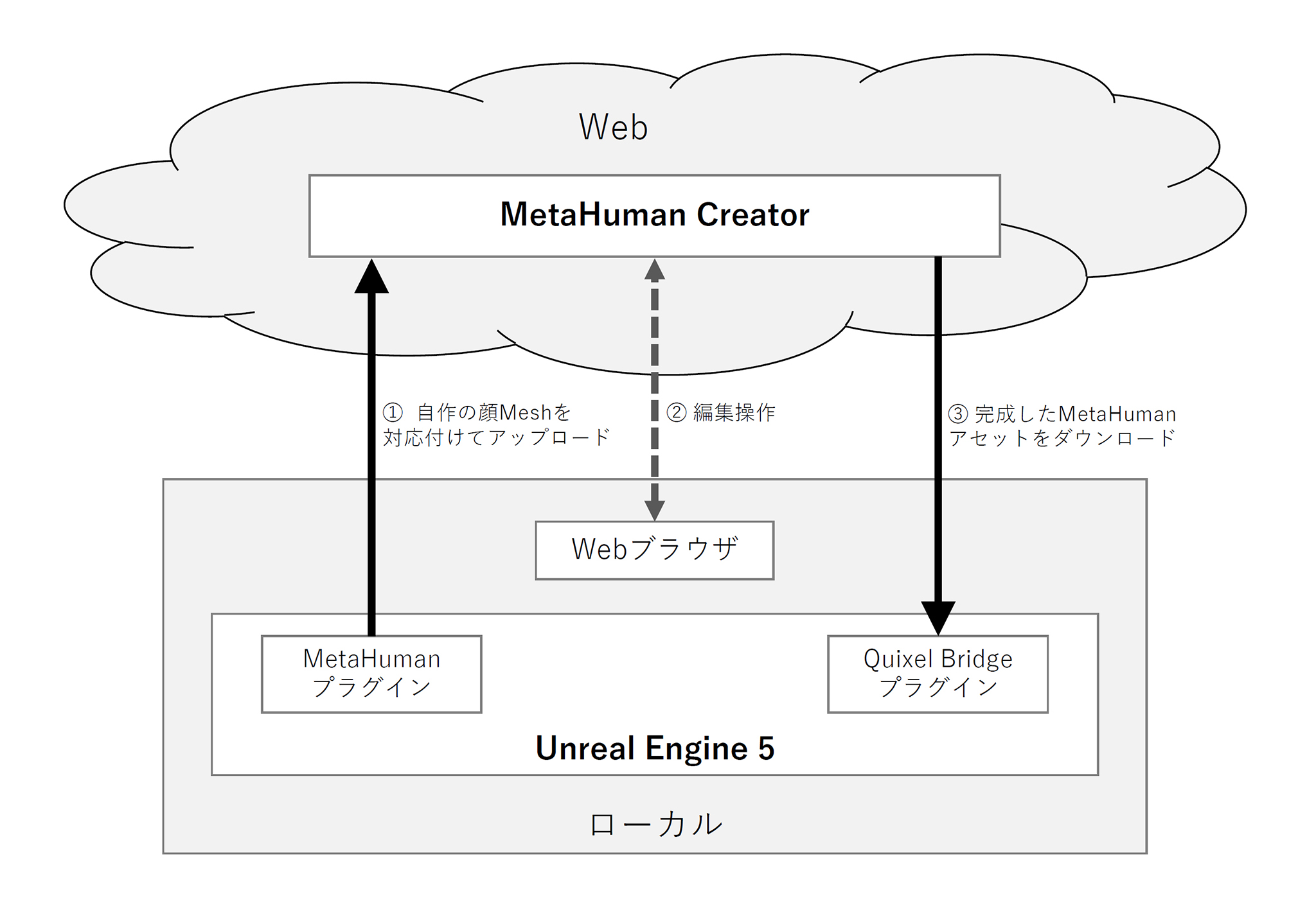

作業に入る前に、作業の全体像と各工程で使うツールの関係を整理して把握しておこう。

チュートリアル動画によると、

- 自作の顔Meshを対応付けてMetaHuman Creatorへアップロード

- Web上のMetaHuman Creatorで編集

- 完成したMetaHumanアセットをUnreal Engineにダウンロード

という流れらしい。

WebツールであるMetaHuman CreatorとUnreal Engine 5をつなぐのがMetaHumanプラグインとQuixel Bridgeプラグイン。

概念を理解しやすいように「アップロード」という言葉を使ったけど、厳密には自作Meshそのものをアップロードするわけではなく、自作Meshの形状に合わせてMetaHumanのベースMeshを変形させる情報がMetaHuman Creatorへ送られるんだと思う。

余談ですが、Unreal Engineで何かする時は全体像を概念図にまとめないと理解しづらいですね。

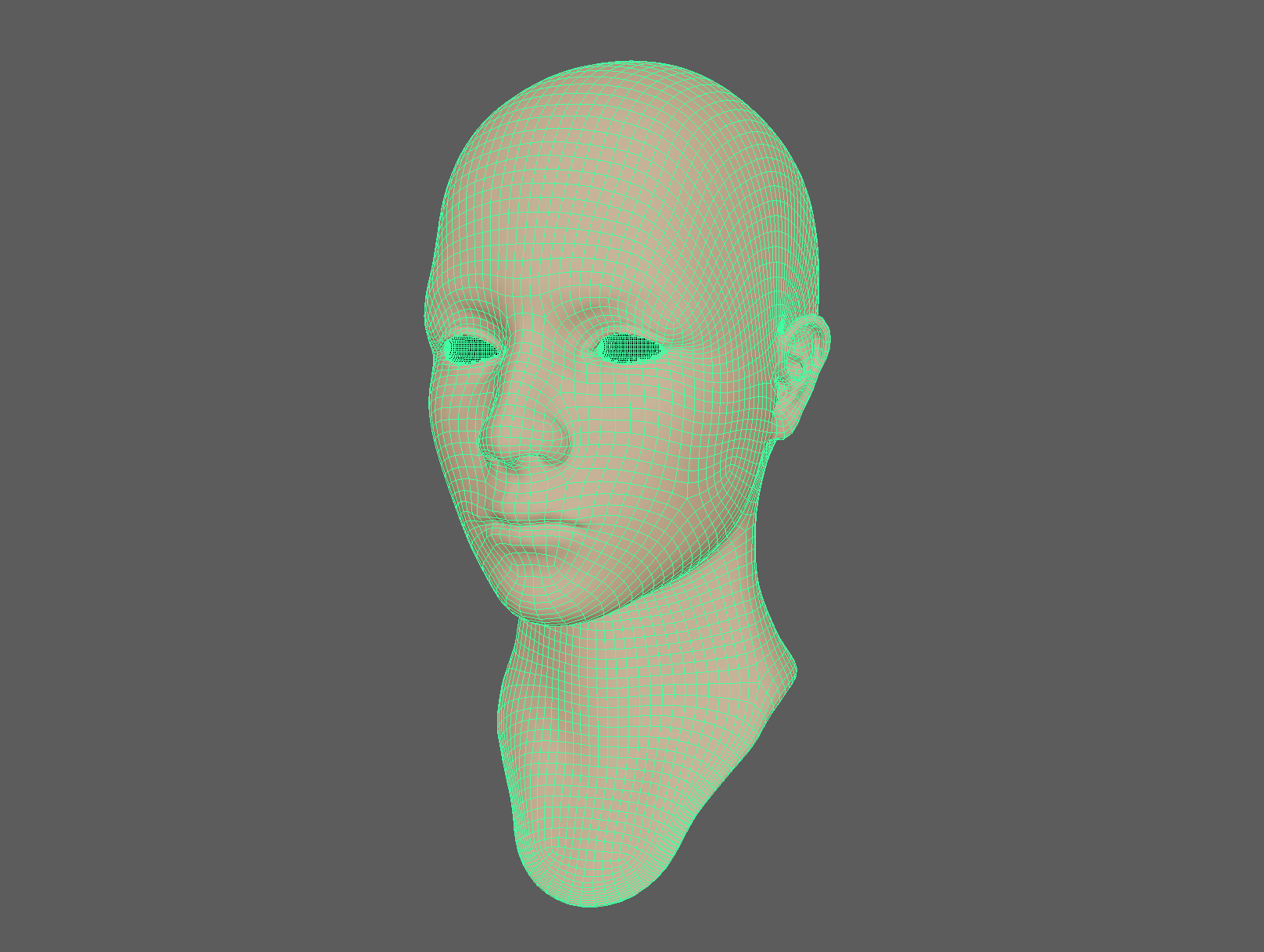

リファインしたポリ男のMeshは、一応Maya上でスケールなどを調整してキレイなFBXファイルにしておく。

MetaHumanの作成

Mesh to MetaHuman

Unreal Engine 5で空のシーンを作成し、MetaHumanプラグインとQuixel Bridgeプラグインを有効にする。

自作した顔Mesh ポリ男をUnreal Engineのシーンにインポート。

テクスチャもマテリアルも用意していないのでこのまま。

MetaHuman Identityアセットを作成し、ポリ男のMeshとMetaHumanのベースMeshを対応づける。(MetaHuman Identityの解決)

画像認識で言うところの顔器官検出(face alignment)みたいな処理で自動的に対応づけられるけど、ちょっと気に入らなかったので手で少し修正した。おそらくこの処理はテクスチャありの方が精度が上がるだろう。

体格なども設定してMetaHuman Identityアセットを保存。

MetaHuman Creatorへアップロード(MeshをMetaHumanに変換)

MetaHumanの編集

Web上のMetaHuman Creatorで形状の微調整や各種テクスチャを設定していく。

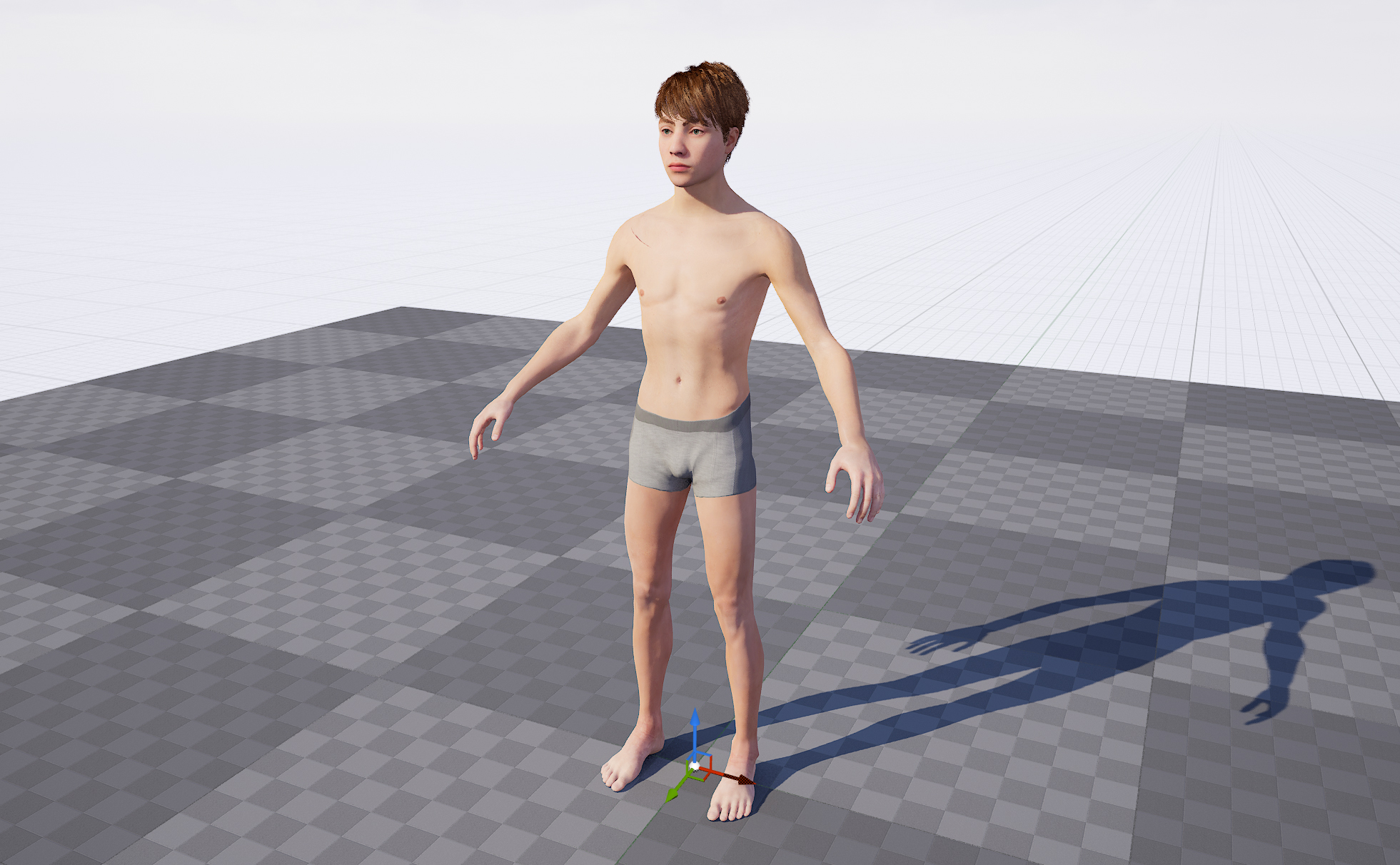

最終的にこんな感じになった↓

MetaHumanアセットのダウンロード

完成したMetaHumanアセットをQuixel Bridgeプラグインを使ってUnreal Engineにダウンロード、シーンにインポートする。

アップロードに使ったシーンとは別のシーンにももちろんインポートできる。

Live Link Faceで顔を動かす

せっかくなので、作成したMetaHumanを動かしてみよう。Unreal Engineが配布しているiPhoneアプリLive Link Faceを使ってみる。

Live Link Faceを使えば、iPhoneのカメラで撮影した自分の顔の表情を認識してUnreal Engine上のキャラクターの顔に反映できる。

https://www.unrealengine.com/ja/blog/new-live-link-face-ios-app-now-available-for-real-time-facial-capture-with-unreal-engine

https://docs.unrealengine.com/5.0/ja/recording-face-animation-on-ios-device-in-unreal-engine/

MetaHumanとの連携方法はこちらの記事を参考にした↓

https://zenn.dev/iwaken71/articles/metahumans-livelink

Unreal Engineを起動しているPCとiPhoneを同一ネットワークに接続し、Live Link FaceアプリからUnreal Engineを起動しているPCのIPアドレスを指定するだけで動かせる。

で、Unreal Engineのシーン上で動かしてみたのがこちら↓

表情を反映する影響度が何故か左右で違い、表情が歪んでしまう。。。

現時点ではまだ自作Meshから作ったMetaHumanでは顔のリグに不具合があるらしい。

対処方法もあるにはあるようだ↓

https://mohumohu-tech.com/2022/07/14/metahuman%e3%81%ae%e3%83%95%e3%82%a7%e3%82%a4%e3%82%b7%e3%83%a3%e3%83%ab%e3%81%8c%e3%81%aa%e3%82%93%e3%81%8b%e5%a4%89%e3%81%ab%e3%81%aa%e3%81%a3%e3%81%a6%e3%81%84%e3%82%8b/

追記:↑この記事で配布してくれているファイルを利用して対処してみた↓

制作記事まとめページ↓

人間のCGを作るツールはどんどん進化しますね。

http://www.makehumancommunity.org/

関連記事

タダでRenderManを体験する方法

bpy-renderer:レンダリング用Pythonパッケー...

3Dスキャンしたテクスチャから照明を除去するUnityツール...

ZBrush 2018での作業環境を整える

PolyPaint

『スター・ウォーズ/スカイウォーカーの夜明け』のVFXブレイ...

Open Shading Language (OSL)

3Dスキャンに基づくプロシージャルフェイシャルアニメーション

AndroidもopenGLも初心者さ (でもJavaは知っ...

自前Shaderの件 解決しました

ManuelBastioniLAB:人体モデリングできるBl...

Structure from Motion (多視点画像から...

フォトンの放射から格納までを可視化した動画

MeshLab:3Dオブジェクトの確認・変換に便利なフリーウ...

Leap MotionでMaya上のオブジェクトを操作できる...

Paul Debevec

Composition Rendering:Blenderに...

イタリアの自動車ブランドFiatとゴジラがコラボしたCMのメ...

Rerun:マルチモーダルデータの可視化アプリとSDK

Unity ARKitプラグインサンプルのチュートリアルを読...

ZBrushで仮面ライダー3号を造る ベース編

ZBrushでリメッシュとディティールの転送

Adobe Photoshop CS4 Extendedの3...

Ambient Occlusionを解析的に求める

書籍『The Art of Mystical Beasts』...

ラクガキの立体化 モールドの追加

布地のシワの法則性

無料で使える人体3DCG作成ツール

この本読むよ

『シン・ゴジラ』のコンセプトアニメーションのメイキング動画が...

BlenderのRigifyでリギング

Javaで作られたオープンソースの3DCGレンダラ『Sunf...

MRenderUtil::raytrace

UnityでARKit2.0

ラクガキの立体化 3Dプリント注文

MB-Lab:Blenderの人体モデリングアドオン

ZBrushのキャンバスにリファレンス画像を配置する

trimesh:PythonでポリゴンMeshを扱うライブラ...

Stanford Bunny

Mayaでリアルな布の質感を作るチュートリアル

参考になりそうなサイト

Unity Scriptコーディング→Unreal Engi...

コメント