もう半年前のことですが、昨年12月に東京国際フォーラムで開催されたSiggraph Asia 2018 Tokyoで聴講したCourse CreativeAI:Deep Learning for Graphicsの復習を(今頃)しておこうかと。

「CGのためのディープラーニング」とか「CGに使えるディープラーニング」という趣旨でしょうか。

途中休憩を挟んだとはいえ、3時間を超えるセッションは結構しんどくもあり、すぐに咀嚼できなかったのである。

幸い、Courseの資料はWebで公開されている↓

CreativeAI:Deep Learning for Graphics

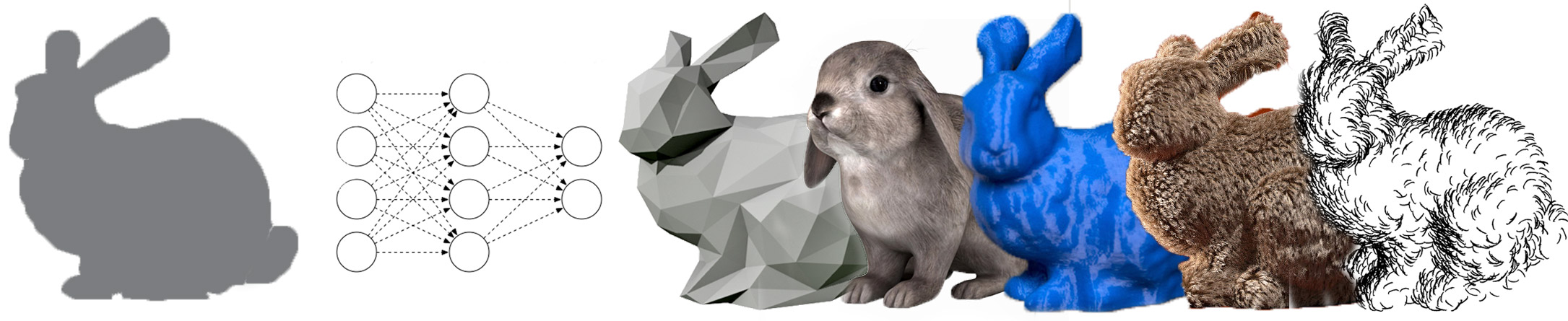

近年、古くからコンピューターグラフィックス分野で課題とされてきたことの多くが、データドリブンな手法 ディープラーニングの登場によって上手く扱えるようになってきた。deep networkは様々な課題設定で利用され、従来のハンドクラフトな手法に圧倒的な差をつけてstate-of-the-artを達成している。

本チュートリアルでは、ディープラーニングの理論、実践、そしてグラフィックス分野へ応用事例を解説する。

いつのまにやらページが更新されていた。このCourseはSiggraph Asia 2018だけでなく、Eurographics 2018でもやってたんですね。

そして、どうやら今年の夏のSiggraph 2019でもこのCourseが設けられるらしい。CG分野でもディープラーニングの注目度はかなり高いようだ。

Courseのサンプルコード(Jupyter)も公開されている↓

https://github.com/smartgeometry-ucl/dl4g

とりあえず、Siggraph Asia 2018で使われた資料で復習していこう。

すでに機械学習やニューラルネットワーク、識別モデル(Discriminative Model)の基本的な知識があるなら、Part 1〜4は読み飛ばして、教師なし学習、生成モデル(Generative Model)についてのPart 5ぐらいから読み始めれば良い。

というか、オイラ自身がまだ教師なし学習や生成モデルについてあんまりよく知らないのである。

http://kento1109.hatenablog.com/entry/2018/01/10/111249

今のところ生成モデルについては

あるドメインの確率分布を学習した生成モデルに任意のパラメータを与えると、必ずそのドメインに収まる生成結果が出力される。

というレンダラのような存在と理解している。

GANの勉強しようと思ってたけど、Autoencoderからちゃんと見て行った方が良さそうだ。

- Autoencoder

- VAE:Variational Autoencoder

- GAN:Generative Adversarial Networks

Part 6で紹介されているように、生成モデルのグラフィックスへの応用は画像がかなり先行している。これはディープラーニングの識別モデルで画像を扱う研究が盛んな恩恵か。畳み込みニューラルネットワークが大活躍。

Part 7では、CG分野で使われる3Dデータをニューラルネットワークで扱えるベクトルの形に落とし込んで畳み込むための様々な工夫が紹介されている。

最近、GitHubで3Dのデータを扱った機械学習手法をまとめているリポジトリの存在を知った↓

https://github.com/timzhang642/3D-Machine-Learning

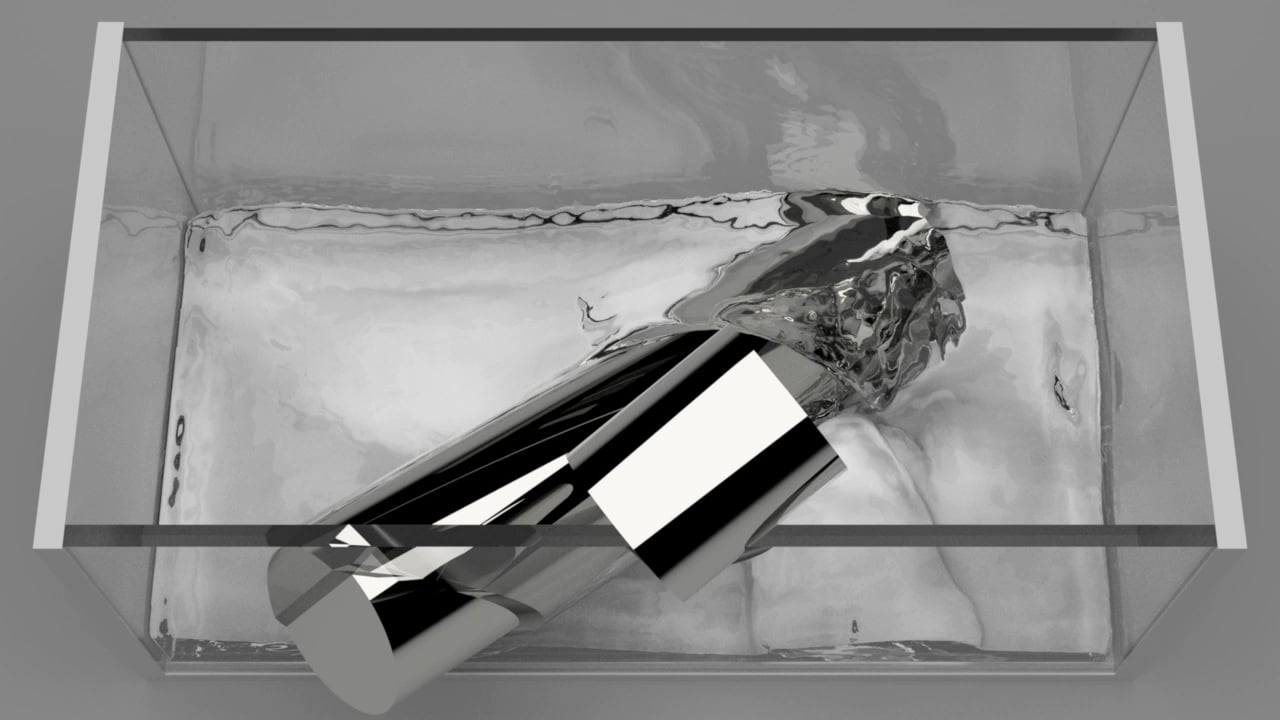

Part 8ではモーションのパラメータを少ない次元に圧縮して表現したり、粗い流体シミュレーションを超解像化したり。

そういえば、流体シミュレーションを機械学習で近似して高速化するアプローチもありましたね↓

う〜ん、復習しようにも案外スライドに載っている情報は少なかったな…

このCourseでは触れられてなかったけど、CGレンダリングの各プロセスを微分可能にするアプローチはどういうジャンルなんだろう。

Neural 3D Mesh Rendererが有名だけど。

https://qiita.com/no_more_syakai/items/f1358e33e8376ae1766d

http://ai-scholar.tech/treatise/renderer-ai-215/

とりあえずPyTorch実装を読んでみるか?

https://github.com/daniilidis-group/neural_renderer

CGのためのディープラーニングについて、もうちょっと詳しい情報がないかと探していたら、電子情報通信学会の総合大会で筑波大学の金森先生が講演したスライドが公開されていた↓

CG分野は人間が手作業で多次元のパラメータを編集していると考えると狂気の世界だけど、CGって従来そういう人達が牽引してきた産業なのよね。

パラメータをいじってはレンダリング結果を確かめる試行錯誤って、機械学習と似ている気もする。

追記:とりあえずGANについて勉強し始めた↓

2020年6月 追記:Hands-on Workshop Machine Learning and Neural Networksの動画が公開されたぞ↓

関連記事

AfterEffectsプラグイン開発

ZBrushのTranspose Masterでポーズを付け...

オープンソースの物理ベースGIレンダラ『appleseed』

OpenAR:OpenCVベースのマーカーARライブラリ

Adobe Photoshop CS4 Extendedの3...

ZBrushでメカ物を作るチュートリアル動画

昔Mayaでモデリングしたモデルをリファインしてみようか

Maya には3 種類のシェーダSDKがある?

PythonでBlenderのAdd-on開発

ZBrushトレーニング

スクラッチで既存のキャラクターを立体化したい

CGWORLD CHANNEL 第21回ニコ生配信は『シン・...

SDカードサイズのコンピューター『Intel Edison』

Alice Vision:オープンソースのPhotogram...

TensorSpace.js:ニューラルネットワークの構造を...

Unityの薄い本

ZBrushでアヴァン・ガメラを作ってみる 全体のバランス調...

白組による『シン・ゴジラ』CGメイキング映像が公開された!

2012のメイキングまとめ(途中)

MeshroomでPhotogrammetry

ZBrushの練習 手のモデリング

Human Generator:Blenderの人体生成アド...

Adobe MAX 2015

Point Cloud Consortiumのセミナー「3D...

Zibra Liquids:Unity向け流体シミュレーショ...

FacebookがDeep learningツールの一部をオ...

布のモデリング

『ローグ・ワン/スター・ウォーズ・ストーリー』のVFXブレイ...

LuxCoreRender:オープンソースの物理ベースレンダ...

After Effects全エフェクトの解説(6.5)

openMVG:複数視点画像から3次元形状を復元するライブラ...

Structure from Motion (多視点画像から...

SegNet:ディープラーニングによるSemantic Se...

iPhoneで3D写真が撮れるアプリ『seene』

自前Shaderの件 解決しました

ラクガキの立体化 目標設定

OpenCV3.3.0でsfmモジュールのビルドに成功!

HTML5・WebGLベースのグラフィックスエンジン『Goo...

ZBrushCoreのTransposeとGizmo 3D

生物の骨格

ドラマ『ファーストクラス』のモーショングラフィックス

ヘッドマウントディスプレイとビジュアリゼーションの未来

コメント