Amazonの新しいスマホに搭載されてちょっと話題になったけど、カメラから画像認識技術を使ってユーザーの視線を計算すれば、2Dの普通のディスプレイでも疑似的に3D映像を表示することができる。Amazonはこの疑似表示方法をDynamic Perspectiveと呼んでいる。

これは、対象ユーザーが1人の場合に可能な方法で、ユーザーの目の移動に合わせてディスプレイに表示する映像を変化させることで、奥行きを感じさせるもの。スマホのように手に持つなど、目とディスプレイの位置関係が手振れなどで常に変動する環境が前提。両者の位置が静止した関係では立体感を表現できない。

https://www.youtube.com/watch?v=RvOIpN7ZiVg

個人的にこの考え方は非常に好き。この考え方というのは、表示を3Dにすることでよりリッチにしようって考えのこと。3Dテレビが盛り上がらなかったせいなのか、割と「3Dは無意味」って認識が根強いんだけど、コンテンツを作りづらいのが普及の一番の足かせだったと思う。日常生活で空間認識している状態に近い情報提示手段の方が、より直観的なUIだとオイラは考えている。

もちろん2Dの方が相応しい場合もあるとは思うけど、3Dだから可能になることもたくさんあるんじゃないだろうか。文書みたいなデスクトップのパラダイムで生まれた情報は確かに2Dの方が良いんだけどさ。

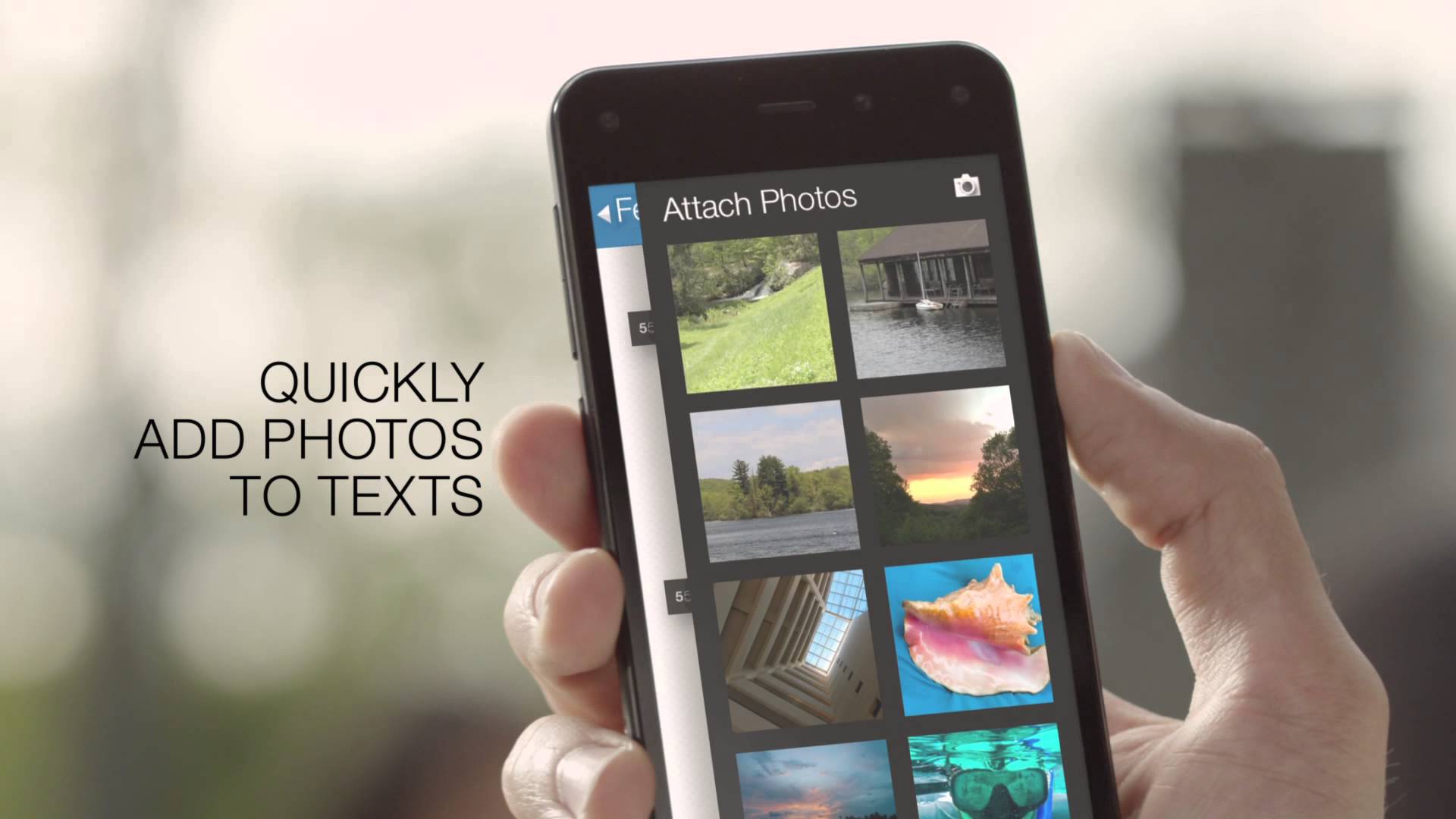

アマゾン初のスマートフォン「Fire Phone」レビュー(前編)–3D効果やデザインなど

アマゾン初のスマートフォン「Fire Phone」レビュー(後編)–アプリや機能、性能など

ちなみに、カメラ画像からの顔追跡には日本のオムロン社のエンジンが使われているらしい。同じ原理でiPadでもソフトウェア的に3D表示を実装することができる。

iPadで実装した例↓

顔や視線でコントロール コンピュータビジョンのセカイ – 今そこにあるミライ

コメント