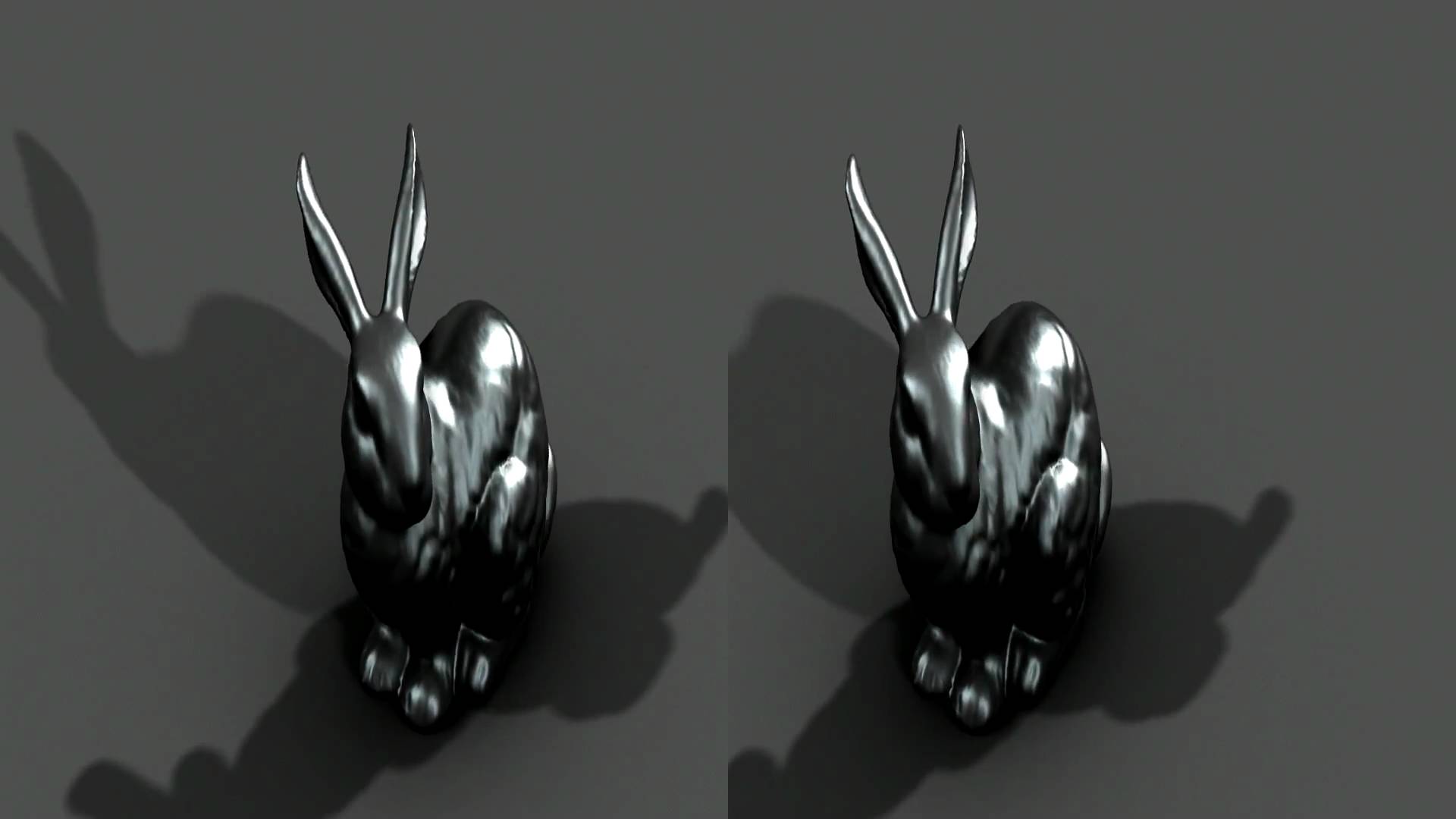

最近、立体視用のモニタ(偏光メガネで見るやつ)を1つ後輩から強奪した譲り受けたんで、適当に視差を作って色々試してみた。(youtubeは立体視にも対応してるんですね)

ちょっとやってみた感想としては、どうやら視差があり過ぎると人間の眼の認識が追いついて来ない感じ。(ちなみに、人間の平均的な両眼距離は6.5cmだそうです)

被写体とカメラの距離、画角、二つのカメラの注視点もちゃんと考えないといけない模様。(まあ、当然か)

眼はモニタ画面を注視するわけだけど、視差が大きくて像がかなり手前に飛び出す場合、手前を注視する感覚へ反射的に頭を切り替えるのがなかなか難しい。(自分だけかもしれないけど)

ただ、人間が認識しやすいように視差を減らすと、じゃあ立体視の意味があるのかという話でもある。

それから、これは偏光方式の質の問題もあると思うけど、像を立体として認識するには、色も重要な要素なんじゃないかと。オイラの作った視差動画は色味がほとんど無いんで、眼が認識しづらかったんじゃないだろうか。偏光メガネでも反対の眼用成分を完全に遮断できないようで、色味が無いと薄っすら見える反対成分と混同して認識してしまう。ということで予想としては、モノクロで視差を作っても効果が薄いんじゃないだろうか。(閲覧環境の質に依存する要素だけど)

ところで、以前もMayaのバージョンを上げた時にちょっと問題が発生した自前Shaderなんだけど、今回バッチ処理でさらに問題発覚。カレントフレームではレンダリングできるのに、バッチに投げると全く描画されなくなる。てっきりレンダーレイヤーの設定を間違えたのかと思ってたんだけど、そういうわけじゃないらしい。バッチに投げると、Shaderを割り当てられてたオブジェクトがまるで透明になったかのように影も形も出ない状態に。バージョンのせい?64bitにしたせい?わからん。

追記:バッチに投げるとShaderが動かない原因はどうやらMTypeIDのせいらしい。環境が変わったことでIDが他のノードとかぶったりしてるのかも。オイラがいいかげんにIDつけてたのがいけなかった。こういうところはスクリプトに劣る部分だな。

コメント