7月にDALL-E2やMidjourneyが公開されて以降、画像生成AIの話題が尽きない。

ほんの2,3ヶ月の間に、文章から画像を生成するtext to imageの新しい研究やサービス・ツールへの移植が毎日のように次々と公開されている。

https://note.com/yamkaz/m/mad0bd7dabc99

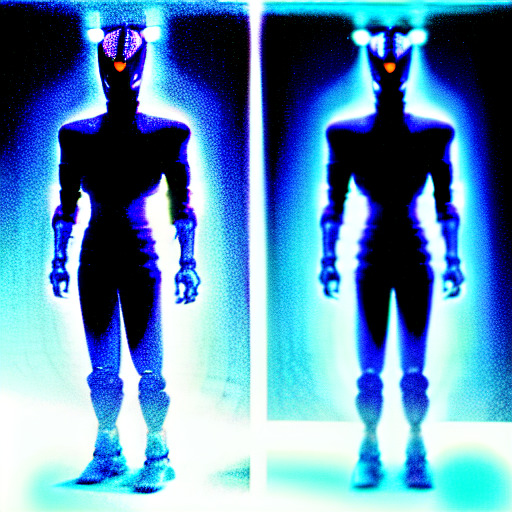

オイラも8月にMidjourneyを無料枠で試してみた↓

話題のmidjourneyに「H・R・ギーガーが描いたウルトラマン」を頼んだ結果#midjourney pic.twitter.com/dV9ANULIdO

— NegativeMind (@NegativeMind) August 5, 2022

Stability.Aiがtext to image手法の1つであるStable Diffusionをオープンソースで公開したことで、text to imageが色んなサービスやツールに組み込まれて一気に手軽に試せるようになった。

https://huggingface.co/CompVis/stable-diffusion-v1-4

https://github.com/CompVis/stable-diffusion

text to imageを利用できる有料サービスに課金しても良いけど、今はかなり円安なのでできれば自分のPCローカルでtext to image動かして好き放題遊びたい。そこそこ良いスペックのPCはあるので。

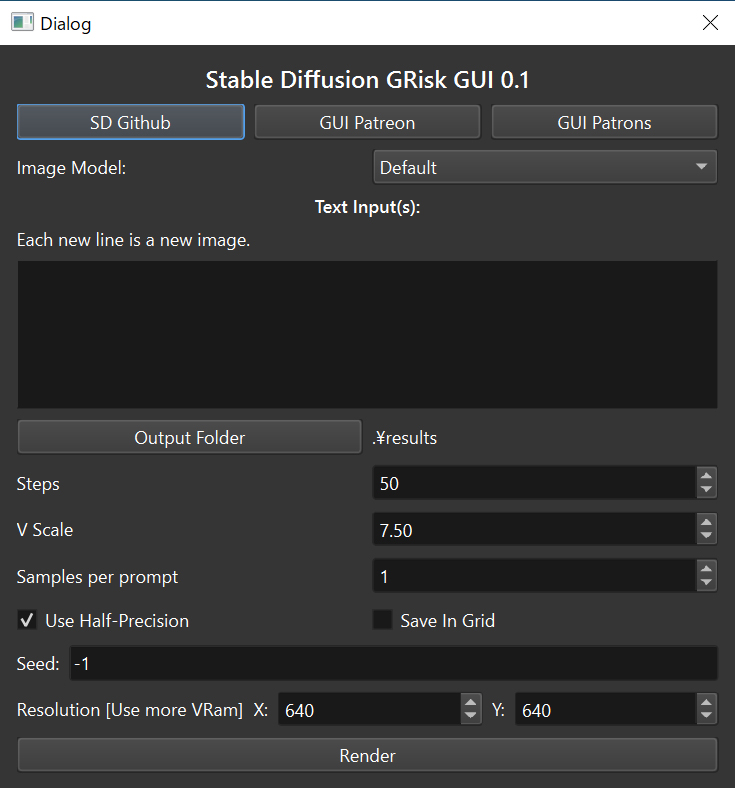

少し調べてみると、今のところ最も手軽にtext to imageをローカルで試せるのはStable DiffusionをGUIで包んだこちらのアプリケーション↓

Stable Diffusion GRisk GUI

Stable Diffusionのモデルを実行するためのインターフェイスです。つまり、テキストのpromptを入力するとそれに対応した画像が返ってきます。

これは超アルファ版であるため、多くのバグがある可能性があります。Stable Diffusion GRisk GUI.exeを実行するだけで使用できます。

生成する画像の解像度設定は64の倍数(64, 128, 192, 256など)である必要があり、512×512解像度が最も良い生成結果を得られます。

重要事項:

- 一部のGTX 1660カードでは、Use Half-Precisionで実行すると問題が発生すると判明しています。(現時点でGUIではこのオプションにしか対応していません)

- Samples per promptはまだ機能しておらず、promptごとに常に1つの画像が生成されます。同じpromptを複数行繰り返せばSamples per promptと同等の効果を得られます。

- 512X512で良好な結果を得られますが、他の解像度は品質に影響を与える可能性があります。

- Step数を多くするとより品質が向上します。Step数を増やしてもメモリ消費量は増えず、処理時間が長くなります。

- 150 Step以下から始めると良いでしょう。

- .exeの起動時に以下のエラーが表示されてもアプリは引き続き動作します。

torchvision\io\image.py:13: UserWarning: Failed to load image Python extension:torch\_jit_internal.py:751: UserWarning: Unable to retrieve source for @torch.jit._overload function:

. warnings.warn(f"Unable to retrieve source for @torch.jit._overload function: {func}.")

torch\_jit_internal.py:751: UserWarning: Unable to retrieve source for @torch.jit._overload function:

. warnings.warn(f"Unable to retrieve source for @torch.jit._overload function: {func}.")

オイラの環境だと640×640解像度まではエラー無く動作したけど、推奨解像度の512×512の方が生成品質は良くなるらしいです。

https://note.com/abubu_nounanka/n/n496a98677201

追記:もっとリッチなGUIアプリがあった↓

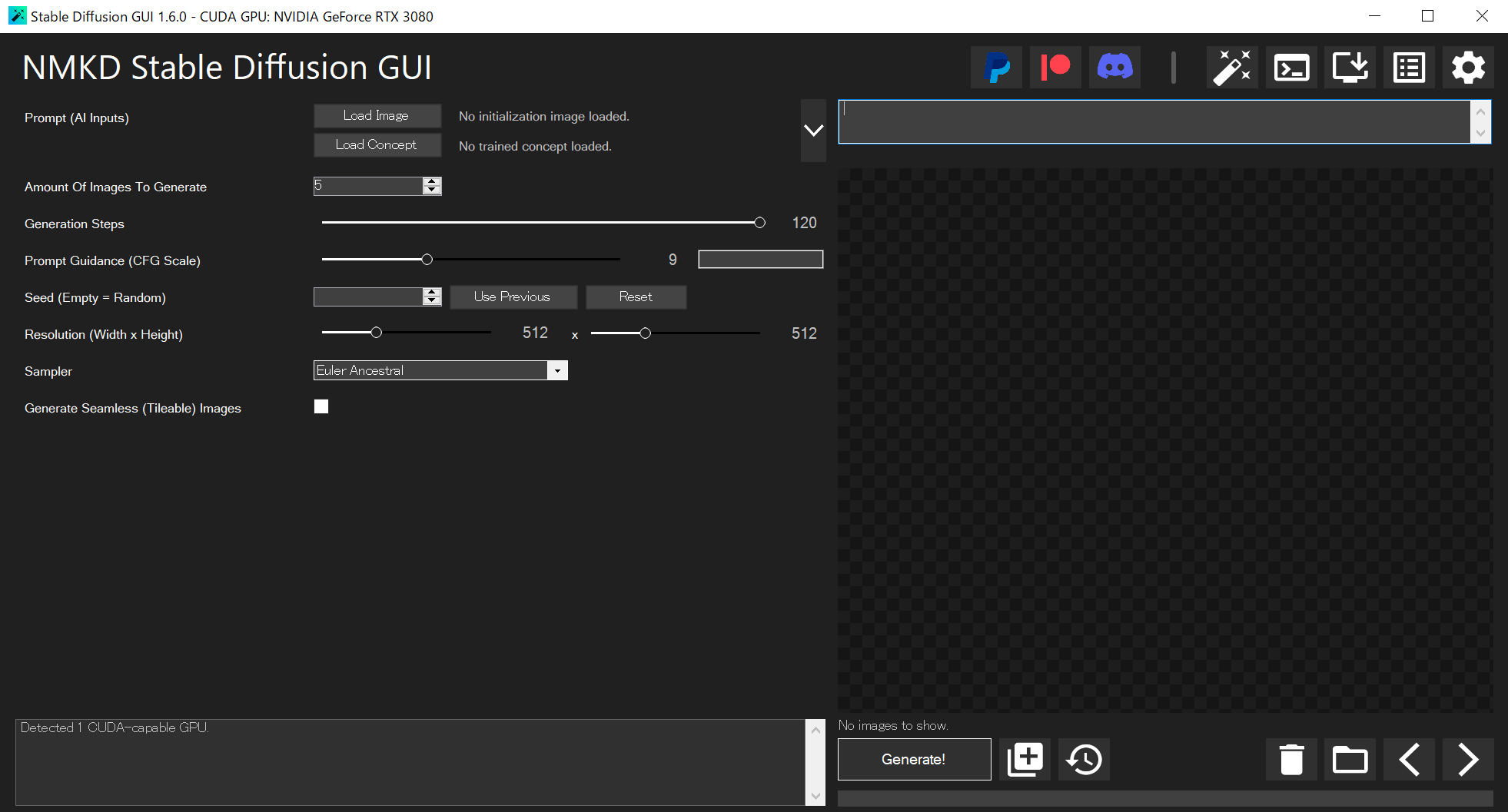

NMKD Stable Diffusion GUI

https://github.com/n00mkrad/text2image-gui

https://pajoca.com/stable-diffusion-gui-nmkd/

https://pajoca.com/stable-diffusion-gui-img2img/

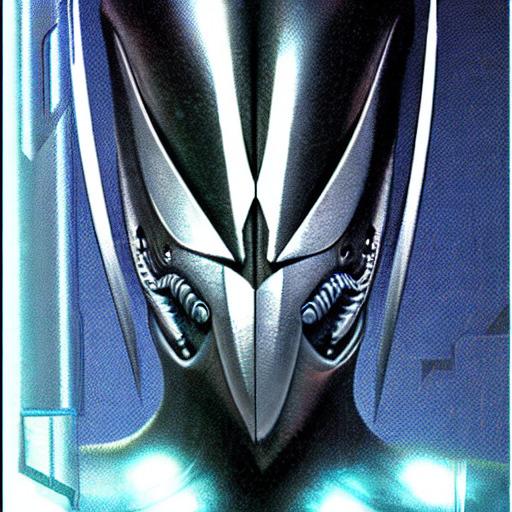

promptとパラメータを色々工夫して好みの画像生成を模索してみた結果↓

ハイスペックなPCを持っていれば、パソコンを起点とした遊びは充実するね。

もはやGANの時代ではないらしい。Stable Diffusionの仕組みについてちゃんと勉強したいなぁ。

https://ja.stateofaiguides.com/20221012-stable-diffusion/

追記:Stable Diffusionをスマホローカルで動作させた例もチラホラ

The #stableDifusion running on-device on iOS beta is out! Running iOS 16 only right now. These took me about 4:30-5 min on my iPhone 14 Pro https://t.co/41OQSJQHC4

Also, signup here if you haven’t already to learn about the actual launch https://t.co/7tpiedKeJz pic.twitter.com/Q0G82BC4qb

— Matt Waller (@wattmaller1) October 15, 2022

I got Stable Diffusion running on my phone this weekend. It's slow, but usable! Code is here: https://t.co/mwq0YQiNcU pic.twitter.com/Ft29LWOk5p

— Ollin Boer Bohan (@madebyollin) October 9, 2022

関連記事

機械学習のオープンソースソフトウェアフォーラム『mloss(...

CGALDotNet:計算幾何学ライブラリ CGALのC#ラ...

ゴジラ(2014)のメイキング

UnityからROSを利用できる『ROS#』

FreeMoCap Project:オープンソースのマーカー...

ミニ四駆を赤外線制御したりUnityと連携したり

ZBrushのUV MasterでUV展開

触れば分かる ユニバーサルデザインな腕時計『The Brad...

粘土をこねるようなスカルプトモデリング

CEDEC 2日目

トランスフォーマー/リベンジ Blue-Ray 予約開始

PyTorch3D:3Dコンピュータービジョンライブラリ

ZBrush キャラクター&クリーチャー

OpenVDB:3Dボリュームデータ処理ライブラリ

SegNet:ディープラーニングによるSemantic Se...

Composition Rendering:Blenderに...

OpenMVSのサンプルを動かしてみる

SculptrisとBlenderで作ったGodzilla ...

ドラマ『ファースト・クラス』第2弾 10月から放送

アニゴジ関連情報

物理ベースレンダリングのためのマテリアル設定チートシート

Theia:オープンソースのStructure from M...

ZBrushでカスタムUIを設定する

Autodesk Mementoでゴジラを3次元復元する

オープンソースの顔の動作解析ツールキット『OpenFace』

スマホでカラーチューニングできるペンライト『KING BLA...

『スター・ウォーズ/スカイウォーカーの夜明け』のVFXブレイ...

LLM Visualization:大規模言語モデルの可視化

ドラマ『ファーストクラス』が面白い

Rerun:マルチモーダルデータの可視化アプリとSDK

UnityのAR FoundationでARKit 3

ZBrushで仮面ライダー3号を造る 仮面編 リファレンス画...

クライマックスヒーローズ

iPhone・iPod touchで動作する知育ロボット『R...

ZBrushでアヴァン・ガメラを作ってみる 全体のバランス調...

コンピュータビジョンの技術マップ

Leap MotionでMaya上のオブジェクトを操作できる...

JavaによるCGプログラミング入門サイト (日本語)

機械学習に役立つPythonライブラリ一覧

ポリゴンジオメトリ処理ライブラリ『pmp-library (...

『シン・ゴジラ』のコンセプトアニメーションのメイキング動画が...

Adobe Photoshop CS5の新機能

コメント