だいぶ前にSeleniumの存在を知っておきながら、まともに試さず時間が経った。

Selenium WebDriverをPythonから叩けばスクレイピングもお手軽だよなぁ、と思い始めた。

Python環境でもpipで簡単にSeleniumをインストールできる。

ブラウザはChromeを使いたいので、別途ブラウザ用のWebDriverとしてChromeDriverもダウンロードした↓

https://sites.google.com/a/chromium.org/chromedriver/

PythonからWebDriverの実行ファイルを叩くような使い方をするらしい。

スクレイピングでSeleniumを使う1番のメリットは、ログインが必要なサイトや、JavaScriptの実行を求めるサイトでも普通のブラウザ操作としてコードが書ける点。複雑なWebの仕組みを抽象化するためにブラウザを間に噛ます感じ。(全部コーディングでやろうとして苦労したことがある…)

Seleniumでサイトのデータを粗く取得して、Beautiful Soupなどのライブラリで詳細にtextをパースしていけば良いんじゃないかな。

https://blog.negativemind.com/2014/06/15/python%E3%81%AE%E3%82%B9%E3%82%AF%E3%83%AC%E3%82%A4%E3%83%94%E3%83%B3%E3%82%B0%E3%83%A9%E3%82%A4%E3%83%96%E3%83%A9%E3%83%AA%E3%80%8Ebeautifulsoup%E3%80%8F/

始めるにあたって参考にしたのはこちら↓

http://nfnoface.hatenablog.com/entry/2017/03/08/212300

https://dev.classmethod.jp/tool/eclipse/windows-selenium-headless-chrome/

何で急にスクレイピングの勉強を再開したかと言うと、最近は機械学習を手軽に試せるライブラリが充実してきたのに、手元にあんまり面白いデータが無かったから。

そして、個人のPCで試せる程度の演算負荷と考えると、画像よりもtextデータの方が色々と試行しやすい気もしている。単位時間あたりに沢山試せた方が学びがあるんじゃないかな。

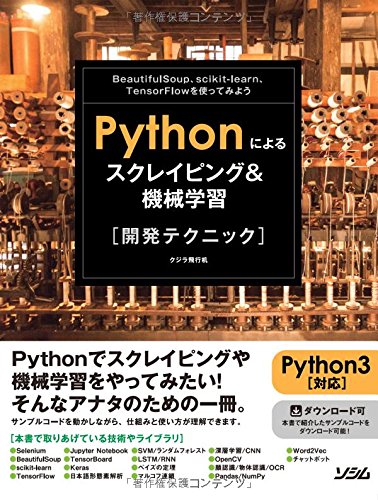

スクレイピングや言語処理にはそれほど詳しくないんだけど、幸い広く浅く紹介している書籍の存在を知った。↓

画像認識にニューラルネットワークを使う理屈は何となく知ってるけど、言語処理については全く知らないので勉強してみたくなった。

最近Qiitaによく使う正規表現のまとめ記事がアップされたので助かる。

https://qiita.com/dongri/items/2a0a18e253eb5bf9edba

スポンサーリンク