書籍「ROSではじめる ロボットプログラミング」を一通り読み終わって、何となくロボットの自己位置認識の重要性を感じている。

ロボット自身の移動量を計測する手法全般を”Odometry“と言うらしい。

中でも1番簡単なやり方は、車輪などの駆動装置の回転数を加算して移動距離とみなす方法。これはWheel Odometryとか呼ばれるらしい。この手法は手軽だがもちろん欠点もあって、車輪が滑るなどして空転した分も移動量として加算されてしまう。そのため、Wheel Odometryではロボットが遠くへ移動するほど、どんどん誤差が溜まってしまう。

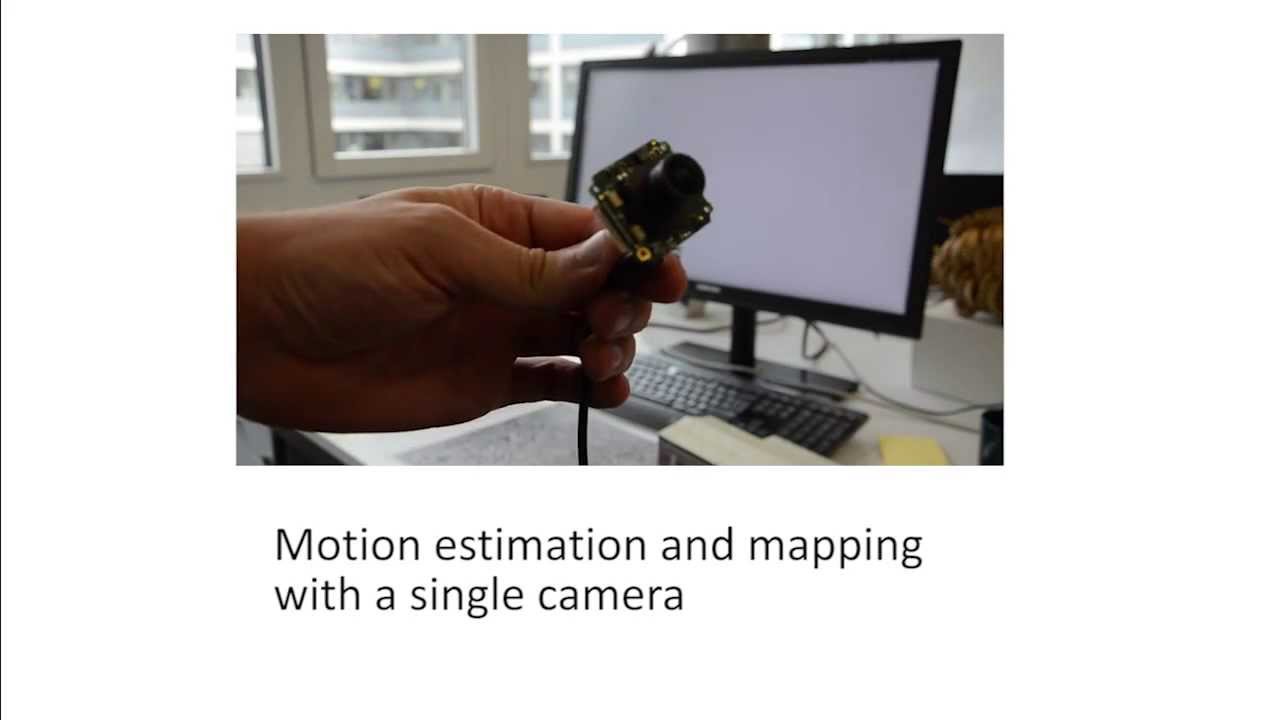

これに対して、カメラ画像を使って自己位置認識を行うのがVisual Odometry(VO)という分野。ロボットの自己位置認識では、ステレオカメラやDepthカメラといった3Dカメラを用いたVisual Odometryの手法がたくさんあるようだ。

以前見たコレは単眼カメラで撮影した2Dの画像を用いて自己位置を認識するMonocular Visual Odometry手法の1つ↓

この技術のすごさがやっと分かってきた。

このSVO(Semi-Direct Monocular Visual Odometry)はROSで試せるようですよ↓

http://kivantium.hateblo.jp/entry/2014/07/01/000651

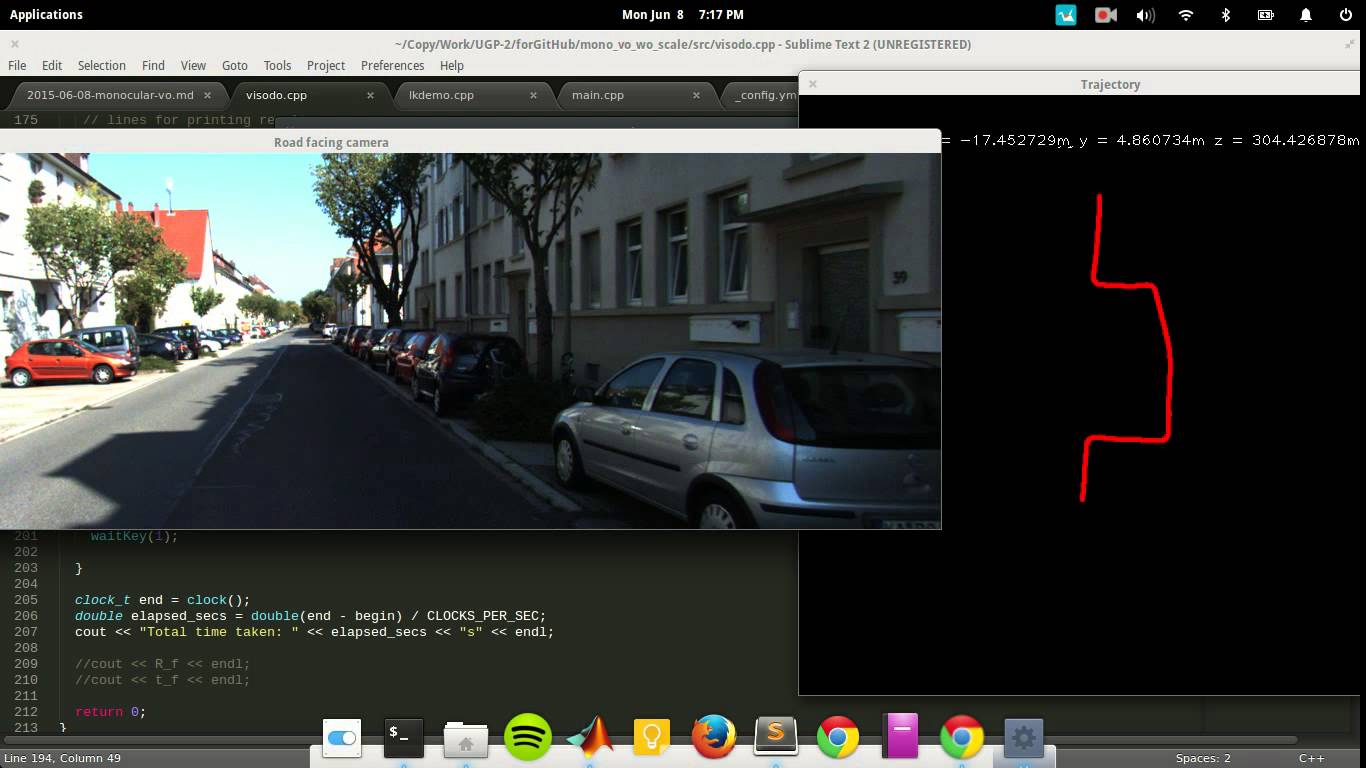

単眼カメラによるVisual Odometry技術に関するチュートリアル、およびOpenCVを使って実装したサンプルが公開されているのを知った↓

https://avisingh599.github.io/vision/visual-odometry-full/

https://avisingh599.github.io/vision/monocular-vo/

ソースコード(C++)はこちら↓

mono-vo

これは、OpenCV 3.0をベースにMonocular Visual Odometry手法(単眼カメラによる自己位置認識)を実装したものです。

アルゴリズム

基本行列の推定にNisterの5点アルゴリズムを使用し、トラッキングにはFAST特徴量とKanade-Lucas-Tomasi Feature Tracker(Lucas–Kanade法)を使用しています。

詳細はこちらのレポートとこちらのブログ記事をご覧ください。

注意事項:

このプロジェクトはまだ相対スケールの推定精度が低いです。そのため、スケール情報はKITTIデータセットのground truthファイルから取得しています。

見たところ、ソースコードはそれほど大規模じゃなさそうだけど、OpenCVを使うとそんなに簡単に書けちゃうものなのだろうか。

追記:中身を読んでみた↓

ここで出てくるKITTIデータセットというのは自動車ビジョン向けの大規模データセットらしいです↓

自動車ビジョン向けの新しい大規模データセット「KITTI Vision Benchmark Suite」

このVisual Odometry技術でロボットの移動量を正確に認識して、さらにその情報から地図を作成するところまで発展するとSLAMなんですかね。(良く解ってない)

2020年5月 追記:最近はPythonでVisual OdometryできるpySLAMというのがありますね↓

https://github.com/luigifreda/pyslam

2通りの再構成方法

カメラで撮影した連続画像(動画)から移動量を測るための再構成方法には大きく2通りあるらしい。

- indirect (feature-based):画像から特徴点を抽出し、疎(sparse)な情報のマッチングで再構成する

- direct:密(dense)な画素情報をそのまま使って再構成する

上記mono-voのコードは特徴点ベースだから、indirectな方法を実装しているということですね。

単眼カメラによるSLAMで有名なLSD-SLAMは、directな手法↓

http://vision.in.tum.de/research/vslam/lsdslam

LSD-SLAMのソースコードは公開されてはいるけど、まだ試せるほど知識がない。

追記:directな手法とindirectな手法を組み合わせたDirect Sparse Odometry(DSO)という手法があるらしい↓

https://vision.in.tum.de/research/vslam/dso

ソースコードもある↓

https://github.com/JakobEngel/dso

追記:第1回3D勉強会@関東でDSOについて解説されていました↓

関連記事

CGのためのディープラーニング

Iridescence:プロトタイピング向け軽量3D可視化ラ...

Kinect for Windows v2の日本価格決定

布のモデリング

AnacondaとTensorFlowをインストールしてVi...

MeshLab:3Dオブジェクトの確認・変換に便利なフリーウ...

顔検出・認識のAPI・ライブラリ・ソフトウェアのリスト

OpenSfM:PythonのStructure from ...

iPhoneアプリ開発 Xcode 5のお作法

ArUco:OpenCVベースのコンパクトなARライブラリ

プログラムによる景観の自動生成

Point Cloud Utils:Pythonで3D点群・...

PCA (主成分分析)

科学技術計算向けスクリプト言語『Julia』

RefineNet (Multi-Path Refineme...

書籍『ROSプログラミング』

Google XML Sitemap Generatorプラ...

UnityからROSを利用できる『ROS#』

Model View Controller

HD画質の無駄遣い その2

Python拡張モジュールのWindows用インストーラー配...

Googleが画像解析旅行ガイドアプリのJetpac社を買収

OpenCVで顔のモーフィングを実装する

iOSで使えるJetpac社の物体認識SDK『DeepBel...

UnityでOpenCVを使うには?

Accord.NET Framework:C#で使える機械学...

ブログが1日ダウンしてました

OpenVDB:3Dボリュームデータ処理ライブラリ

Konashiを買った

OpenAR:OpenCVベースのマーカーARライブラリ

OpenCVで動画の手ぶれ補正

Raspberry Pi 2を買いました

Unity ARKitプラグインサンプルのチュートリアルを読...

Google Chromecast

TorchStudio:PyTorchのための統合開発環境と...

Mayaのプラグイン開発

顔画像処理技術の過去の研究

ZBrushのZScript入門

Pythonの自然言語処理ライブラリ『NLTK(Natura...

Unreal Engineの薄い本

マルコフ連鎖モンテカルロ法

3D Gaussian Splatting:リアルタイム描画...

コメント

[…] monocular-visual-odometry-using-opencv [OpenCV][カメラ] […]

[…] OpenCVでカメラ画像から自己位置認識 (Visual Odometry) […]