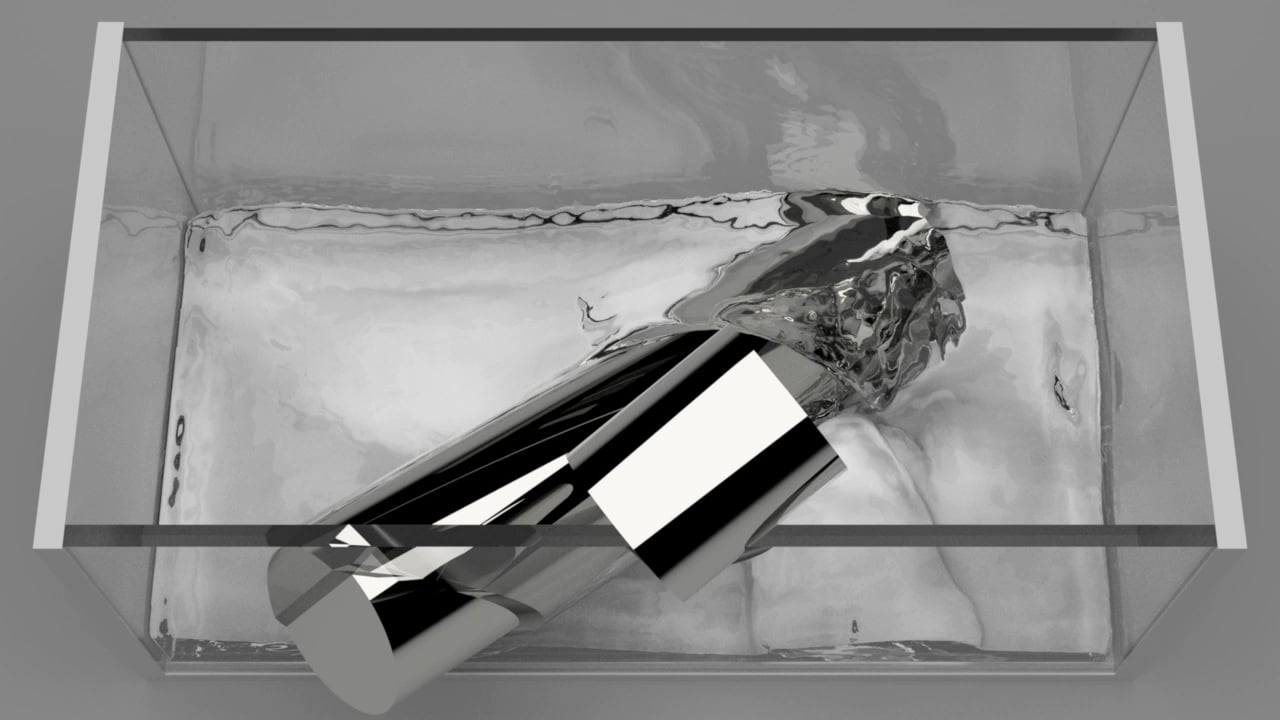

チューリッヒ工科大学(ETH Zurich)、ミュンヘン工科大学、Pixarによるディープラーニングで流体シミュレーションを近似する研究 Deep Fluids: A Generative Network for Parameterized Fluid Simulationsのプロジェクトページとソースコードが公開されている。

Deep Fluids

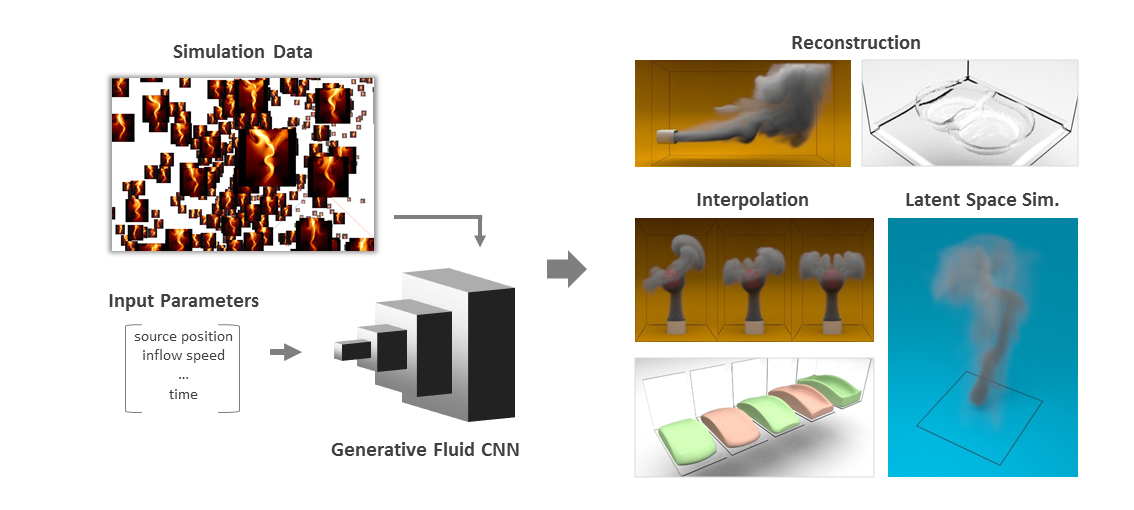

本研究では、削減済みのパラメータセットから流体シミュレーションを合成する新しい生成モデルを提案します。畳み込みニューラルネットワークを離散パラメータ化した流体シミュレーションの速度場(velocity fields)で訓練しました。

訓練データの代表的な特徴を学習するディープラーニングアーキテクチャの特性により、本研究の生成モデルは訓練データセットを正確に近似しつつ、中間値をもっともらしく補間することができます。この生成モデルは、全ての時刻で速度場(velocity fields)の無発散(divergence-free)を保証する新しい損失関数を導入することで流体に最適化されています。

本研究ではさらに、複雑なパラメータを削減した空間で扱えること、潜在空間(latent space)で第2のネットワークと統合することでシミュレーションをリアルタイムに実現できることを示します。

本手法では流体の多種多様な挙動をモデル化しているため、高速なシミュレーション構築、異なるパラメータを持つ流体の補間、タイムリサンプリング、潜在空間(latent space)シミュレーション、シミュレーションデータの圧縮などに応用できます。

本手法による速度場の再構築は、同データをCPUで再シミュレーションするよりも最大で700倍高速に生成でき、圧縮率は最大1300倍となります。

5月に開催されるEurographics 2019で発表されるそうです。

ETH Zurichといえば、数年前にRegression Forestベースの流体シミュレーション近似手法Pysics Forestsを発表していましたね↓

機械学習による流体シミュレーション近似を突き詰めていくと、やっぱりニューラルネットワークに行き着くということなのだろうか。

GitHubで公開されているDeep Fluidsのソースコードを見ると、TensorFlowベースで実装されているようだ↓

https://github.com/byungsook/deep-fluids

mantaflowという流体シミュレーションのフレームワークを使って訓練用のデータセットを用意するんですね↓

mantaflow

mantaflowは、コンピューターグラフィックスでの流体シミュレーションの研究を対象としたオープンソースのフレームワークです。

並列化されたC++のsolverコア、pythonシーン定義のインターフェイス、プラグインシステムにより、新しいアルゴリズムの迅速なプロトタイピング・テストが可能です。mantaflowには広範囲のNavier-Storkes solverの変種が含まれています。

mantaflowはとても用途が広く、ディープラーニングのフレームワーク(例:numpyを介してTensorFlow)と連携してインポート/エクスポートを可能な他、matlabのプラグインとしてスタンドアローンにコンパイルすることもできます。

最新版のダウンロードはこちら。

Physics Forestsで著者の1人にDisney Research所属の人がいたように、Deep Fluidsの著者の中にはPixar所属の人がいますね。

CGで一昔前は物理ベースと言われていたジャンルが、演算コストが頭打ちになってだんだんナレッジ(知識)ベースへと移ってきているということだろうか。

大きな目で見ると、現象をデフォルメして軽い処理で近似していた時代に戻っているような気もする。

多次元パラメータを扱う関数の多いCG分野はディープラーニング(というかニューラルネットワーク)に向いてるのかもな。

畳み込みって、テクスチャマッピングやShading処理そのものだし、GPUとの相性も良い。

https://shiropen.com/seamless/deep-fluids

NVIDIAがGPGPUと言い始めたころ、その使用例は流体計算が多かった気がするけど、時代を経て手を変え品を変え、結局GPUで流体計算しているのも何だか不思議。

関連記事

ラクガキの立体化 モールドの追加

注文してた本が届いた

trimesh:PythonでポリゴンMeshを扱うライブラ...

Mechanizeで要認証Webサイトをスクレイピング

Blenderでよく使うaddon

Raspberry Piでセンサーの常時稼働を検討する

機械学習のオープンソースソフトウェアフォーラム『mloss(...

機械学習に役立つPythonライブラリ一覧

TensorSpace.js:ニューラルネットワークの構造を...

Gource:バージョン管理の履歴を可視化するツール

ヒーローに変身なりきりアーケードゲーム『ナレルンダー』

iOSデバイスのためのフィジカル・コンピューティングツールキ...

映画『ミュータント・タートルズ』を観てきた

Blender 2.81でIntel Open Image ...

Mayaのシェーディングノードの区分

OpenSfM:PythonのStructure from ...

PythonでMayaのShapeノードプラグインを作る

OpenCVでPhotoshopのプラグイン開発

UnityでLight Shaftを表現する

オープンソースの顔の動作解析ツールキット『OpenFace』

ZBrushでカスタムUIを設定する

世界一下品なクマと世界一紳士なクマ

uvでWindows11のPython環境を管理する

トランスフォーマーの変形パターンを覚えるのは楽しいと思うんだ

Pythonの自然言語処理ライブラリ『NLTK(Natura...

bpy-renderer:レンダリング用Pythonパッケー...

pythonの機械学習ライブラリ『scikit-learn』

ZBrush4新機能ハイライト 3DCG CAMP 2010

映画『ブレードランナー 2049』のVFX

Photo Bash:複数の写真を組み合わせて1枚のイラスト...

オープンソースのIT資産・ライセンス管理システム『Snipe...

UnityでPoint Cloudを表示する方法

Autodesk CompositeとAutodesk Ma...

Runway ML:クリエイターのための機械学習ツール

Raspberry Pi 2を買いました

ポリゴン用各種イテレータと関数セット

geometry3Sharp:Unity C#で使えるポリゴ...

UnrealCV:コンピュータビジョン研究のためのUnrea...

WordPress on Google App Engine...

ZBrushでゴジラ2001を作ってみる 身体のSubToo...

ゴジラ三昧

OpenCV

コメント