LLMの仕組みを可視化した教材というと、以前LLM Visualizationを紹介しましたが

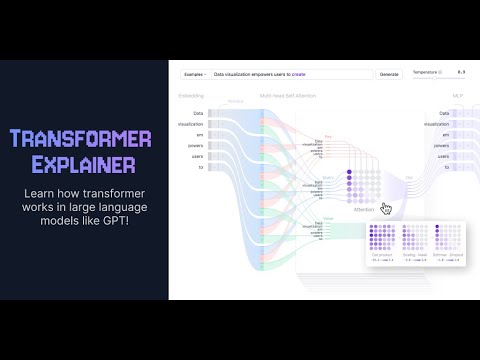

Transformer ExplainerはWebブラウザ上で実際にGPT-2を動作させてその仕組みを視覚的に確認できる↓

Transformer Explainer

Transformer Explainerは、GPT(Generative Pretrained Transformer)などのTransformerベースのモデルがどのように機能するかを誰でも学習できるよう設計されたインタラクティブな可視化ツールです。

ブラウザ上でライブGPT-2モデルを実行し、独自のテキスト入力を試したり、Transformerの内部コンポーネントと操作がどのように連携して次のトークンを予測するのかリアルタイムで観察できます。

このツールについてはTransformer Explainer: Interactive Learning of Text-Generative Modelsという文献としてまとめられている。

GitHubのリポジトリを見て分かるように、開発したコミュニティはCNN Explainerと同じ。

同じく〇〇Explainerシリーズ(?)で、Stable Diffusionを扱ったDiffusion Explainerも存在する。

Transformer Explainerで、現在のディープラーニングで主流のTransformerアーキテクチャと、LLMの根幹である「次トークン予測」の処理がどのような仕組みで実現しているのか、Self-Attention機構による文脈理解がどのように効いているのか視覚的に理解できる。

Transformerとは?

Transformerは、人工知能のアプローチを根本的に変えたニューラルネットワークのアーキテクチャです。Transformerは2017年に発表された画期的論文「Attention is All You Need」で初めて提案されて以降、ディープラーニングモデルの標準的なアーキテクチャとなり、OpenAIのGPT、MetaのLlama、GoogleのGeminiといったテキスト生成モデルを支えています。さらに、テキストだけでなく、オーディオ生成、画像認識、タンパク質の構造予測、ゲームプレイにも応用されており、多様な分野での汎用性を示しています。

テキスト生成型のTransformerモデルは「次の単語を予測する」仕組みをベースに動作します。つまり、ユーザーから与えられたテキスト入力に対して、次に来る確率の最も高い単語を予測します。Transformerの性能の核心はself-attention機構です。これにより、Transformerは入力されたシーケンス全体を処理でき、従来のアーキテクチャよりも長距離の依存関係を効果的に捉えることができます。

GPT-2ファミリーは、テキスト生成型Transformerの代表的な例です。Transformer Explainerは1億2400万のパラメータを持つGPT-2(small)モデルを搭載しています。これは最新のTransformerモデルではありませんが、現在の最先端モデルとアーキテクチャ上の共通点が多いため、基本を理解する出発点として理想的です。

Transformerのアーキテクチャ

テキスト生成型Transformerは全て、主に以下3つのコンポーネントで構成されています。

- Embedding(埋め込み):入力されたテキストはトークンと呼ばれる小さな単位(単語やサブワード)に分割されます。各トークンはそれぞれEmbeddingsと呼ばれる数値ベクトルへ変換されます。このEmbeddingsは、単語の意味的な情報を捉えます。

- Transformerブロックはモデルの基本的な構成要素で、入力データを処理・変換する役割を担います。各ブロックには以下の要素が含まれます:

- Attention機構:Transformerブロックの核となるコンポーネントであり、各トークン同士の関係を捉えることで文脈情報を学習します。

- MLP(多層パーセプトロン)層:各トークンを個別に処理するフィードフォワードネットワークです。Attention層がトークン間の情報をやり取りする役割を持つのに対し、MLPは各トークンの表現を洗練させる役割を担います。

- 確率の出力:処理されたEmbeddingsは最後にLinerとSoftmax層で確率に変換され、次のトークンを予測できるようになります。

関連記事

3D Gaussian Splatting:リアルタイム描画...

UnrealCV:コンピュータビジョン研究のためのUnrea...

GeoGebra:無料で使える数学アプリ

書籍『伝わる イラスト思考』読了

Houdiniのライセンスの種類

CNN Explainer:畳み込みニューラルネットワーク可...

Manim:Pythonで使える数学アニメーションライブラリ

Fast R-CNN:ディープラーニングによる一般物体検出手...

PeopleSansPeople:機械学習用の人物データをU...

Gource:バージョン管理の履歴を可視化するツール

オープンソースのネットワーク可視化ソフトウェアプラットフォー...

書籍『イラストで学ぶ ディープラーニング』

Pylearn2:ディープラーニングに対応したPythonの...

Kaolin:3Dディープラーニング用のPyTorchライブ...

Netron:機械学習モデルを可視化するツール

機械学習について最近知った情報

Runway ML:クリエイターのための機械学習ツール

PyDataTokyo主催のDeep Learning勉強会

Iridescence:プロトタイピング向け軽量3D可視化ラ...

MLDemos:機械学習について理解するための可視化ツール

Caffe:読みやすくて高速なディープラーニングのフレームワ...

ManimML:機械学習の概念を視覚的に説明するためのライブ...

ニューラルネットワークと深層学習

TorchStudio:PyTorchのための統合開発環境と...

TensorFlowでCGを微分できる『TensorFlow...

書籍『仕事ではじめる機械学習』を読みました

Google製オープンソース機械学習ライブラリ『Tensor...

ニューラルネットワークで画像分類

FCN (Fully Convolutional Netwo...

Physics Forests:機械学習で流体シミュレーショ...

Windows10でPyTorchをインストールしてVSCo...

GoogleのDeep Learning論文

pythonの機械学習ライブラリ『scikit-learn』

Raspberry Pi 2のGPIOピン配置

全脳アーキテクチャ勉強会

Google Colaboratoryで遊ぶ準備

NeuralNetwork.NET:.NETで使えるTens...

NeRF (Neural Radiance Fields):...

機械学習での「回帰」とは?

Unreal Engine 5の情報が公開された!

Faster R-CNN:ディープラーニングによる一般物体検...

フィクションに登場するUIデザインのまとめサイト

コメント