Amazonの新しいスマホに搭載されてちょっと話題になったけど、カメラから画像認識技術を使ってユーザーの視線を計算すれば、2Dの普通のディスプレイでも疑似的に3D映像を表示することができる。Amazonはこの疑似表示方法をDynamic Perspectiveと呼んでいる。

これは、対象ユーザーが1人の場合に可能な方法で、ユーザーの目の移動に合わせてディスプレイに表示する映像を変化させることで、奥行きを感じさせるもの。スマホのように手に持つなど、目とディスプレイの位置関係が手振れなどで常に変動する環境が前提。両者の位置が静止した関係では立体感を表現できない。

個人的にこの考え方は非常に好き。この考え方というのは、表示を3Dにすることでよりリッチにしようって考えのこと。3Dテレビが盛り上がらなかったせいなのか、割と「3Dは無意味」って認識が根強いんだけど、コンテンツを作りづらいのが普及の一番の足かせだったと思う。日常生活で空間認識している状態に近い情報提示手段の方が、より直観的なUIだとオイラは考えている。

もちろん2Dの方が相応しい場合もあるとは思うけど、3Dだから可能になることもたくさんあるんじゃないだろうか。文書みたいなデスクトップのパラダイムで生まれた情報は確かに2Dの方が良いんだけどさ。

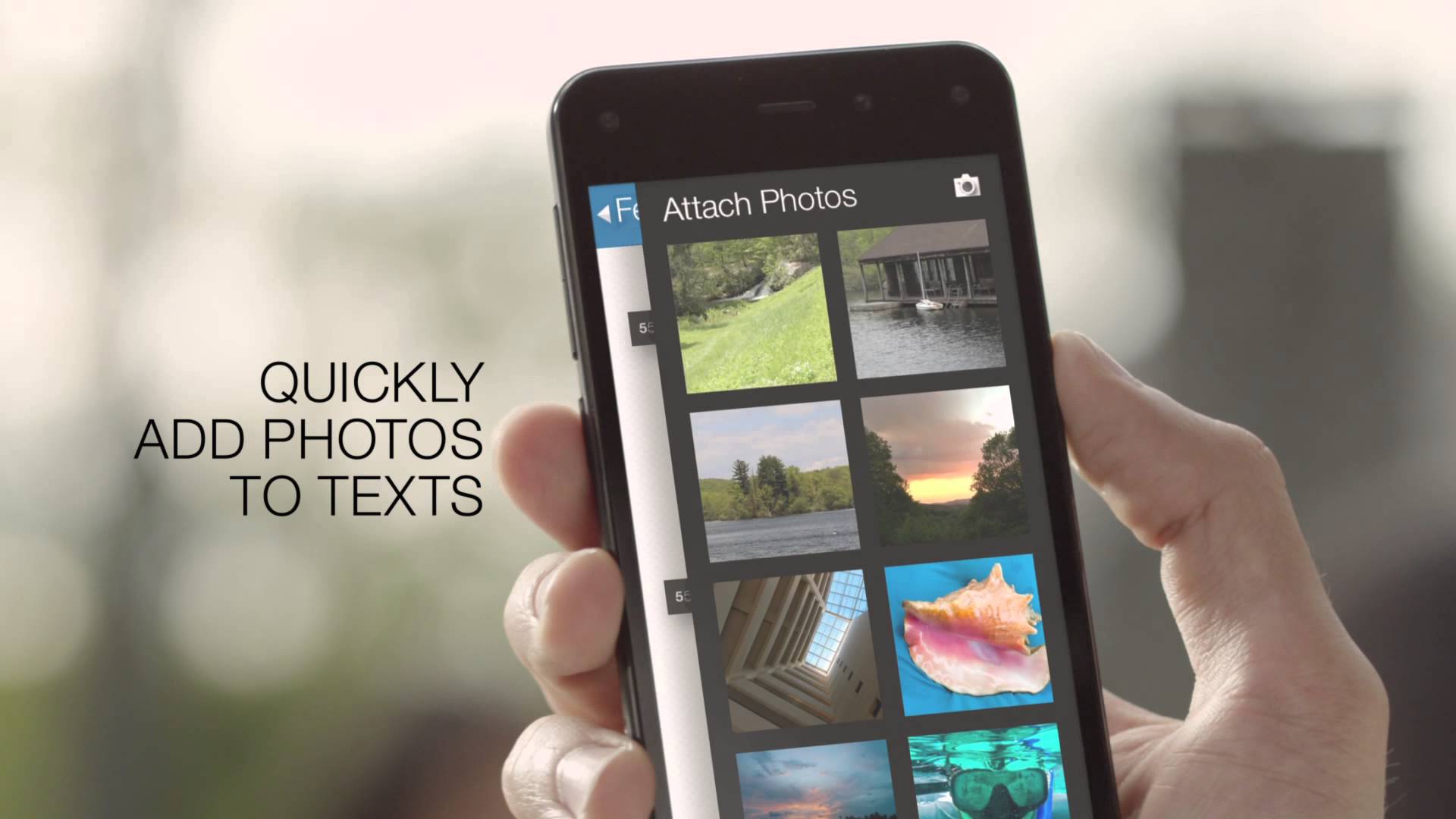

アマゾン初のスマートフォン「Fire Phone」レビュー(前編)–3D効果やデザインなど

アマゾン初のスマートフォン「Fire Phone」レビュー(後編)–アプリや機能、性能など

ちなみに、カメラ画像からの顔追跡には日本のオムロン社のエンジンが使われているらしい。同じ原理でiPadでもソフトウェア的に3D表示を実装することができる。

iPadで実装した例↓

顔や視線でコントロール コンピュータビジョンのセカイ – 今そこにあるミライ

関連記事

CreativeCOW.net

ディープラーニング

OpenCVのfindEssentialMat関数を使ったサ...

実写と実写の合成時の色の馴染ませテクニック

Subsurface scatteringの動画

立体視を試してみた

PeopleSansPeople:機械学習用の人物データをU...

ZBrushのお勉強

ZBrushでUndo Historyを動画に書き出す

顔のモデリング

書籍『イラストで学ぶ ディープラーニング』

UnityのTransformクラスについて調べてみた

ZBrushでアヴァン・ガメラを作ってみる 全体のバランス調...

PyTorch3D:3Dコンピュータービジョンライブラリ

グローバルイルミネーションに手を出す前に、やり残したことがあ...

3DCGのモデルを立体化するサービス

OpenGV:画像からカメラの3次元位置・姿勢を推定するライ...

ManuelBastioniLAB:人体モデリングできるBl...

Blender 2.81でIntel Open Image ...

OpenSfM:PythonのStructure from ...

頭蓋骨からの顔復元と進化過程の可視化

ZBrushのZScript入門

プロシージャル手法に特化した本が出てるみたい(まだ買わないけ...

OpenVDB:3Dボリュームデータ処理ライブラリ

PGGAN:段階的に解像度を上げて学習を進めるGAN

Maya 2015から標準搭載されたMILA

Faster R-CNN:ディープラーニングによる一般物体検...

色んな三面図があるサイト

SSII2014 チュートリアル講演会の資料

株式会社ヘキサドライブの研究室ページ

GoB:ZBrushとBlenderを連携させるアドオン

ZBrushで仮面ライダー3号を造る 仮面編 ClipCur...

ポイントクラウドコンソーシアム

ZBrushでアヴァン・ガメラを作ってみる 頬の突起を作り始...

Raytracing Wiki

ZBrushで基本となるブラシ

フォトンの放射から格納までを可視化した動画

Googleが画像解析旅行ガイドアプリのJetpac社を買収

OpenCVでiPhone6sのカメラをキャリブレーションす...

uGUI:Unityの新しいGUI作成システム

ZBrush 2021.6のMesh from Mask機能...

CEDEC 3日目

コメント