もうだいぶ前の話だけど、3月にあったGDCのセッション「Next-Gen Characters:From Facial Scans to Facial Animation」の情報。

スライド資料はこちらからダウンロードできる。

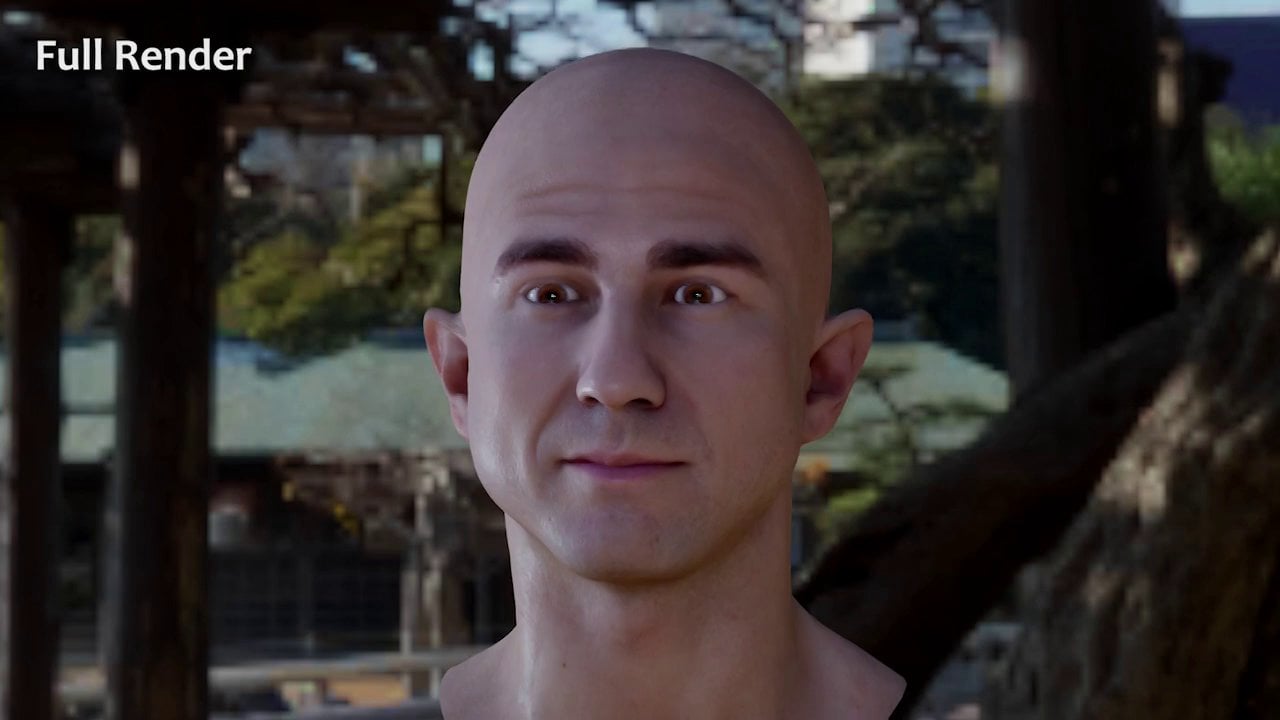

3次元スキャナの性能が向上して、簡単にリアルなモデリングデータを取得できるようになったけど、それにどうリグを入れてアニメーションさせるかが問題。

単に基本的な顔をスキャンして、表情ごとに形状を変化させるだけではダメで、表情それぞれでテクスチャを変える必要もある。顔のデータの変形だけでは、血流量の変化などによる表情の違いまでは表現できない。

GPU Gems 3で解説された「Playable Universal Capture」(Ucap)と、南カリフォルニア大学による「Polynomial Displacement Maps」(PDM)の手法を参考にし、高精度の基本データと低精度だが大量の表情データを組み合わせる手法を採用しているとか。

4Gamer.netの日本語記事が分かりやすいね。

参考:Facial Animation GDC Slides

[GDC 2014]次世代のキャラクターアニメーションはこうなる。フェイシャルキャプチャを用いたプロシージャル処理の実際

関連記事

オープンソースの顔認識フレームワーク『OpenBR』

映画『ジュラシック・ワールド/炎の王国』のVFXブレイクダウ...

日本でMakersは普及するだろうか?

OpenCVのバージョン3が正式リリースされたぞ

物理ベースレンダリングのためのマテリアル設定チートシート

VCG Library:C++のポリゴン操作ライブラリ

オープンソースのネットワーク可視化ソフトウェアプラットフォー...

ZBrushで仮面ライダー3号を造る 仮面編 PolyGro...

ZBrushでゴジラ2001を作ってみる 身体のバランスを探...

ZBrushで仮面ライダー3号を造る 仮面編 横顔のシルエッ...

ZBrushトレーニング

ZBrushで仮面ライダー3号を造る 仮面編 失敗のリカバー

ManuelBastioniLAB:人体モデリングできるBl...

OpenCV 3.1とopencv_contribモジュール...

Photogrammetry (写真測量法)

clearcoat Shader

書籍『OpenCV 3 プログラミングブック』を購入

ZBrushで仮面ライダー3号を造る ベース編

ジュラシック・パークのメイキング

Cartographer:オープンソースのSLAMライブラリ

ポイントクラウドコンソーシアム

PGGAN:段階的に解像度を上げて学習を進めるGAN

ZBrushのハードサーフェイス用ブラシ

ポリ男からMetaHumanを作る

OpenCVの三角測量関数『cv::triangulatep...

OpenGVの用語

ZBrush 2021.6のMesh from Mask機能...

OpenCV 3.3.0 contribのsfmモジュールの...

ZBrushで仮面ライダー3号を造る 仮面編

Blenderでよく使うaddon

レンダラ制作はOpenGL とか DirectX を使わなく...

AR (Augmented Reality)とDR (Dim...

フォトンの放射から格納までを可視化した動画

trimesh:PythonでポリゴンMeshを扱うライブラ...

書籍『3次元コンピュータビジョン計算ハンドブック』を購入

DensePose:画像中の人物表面のUV座標を推定する

FacebookがDeep learningツールの一部をオ...

ZBrushでアヴァン・ガメラを作ってみる 頭頂部の作り込み...

Regard3D:オープンソースのStructure fro...

ZBrushで仮面ライダー3号を造る 仮面編 DynaMes...

オープンソースのテクスチャマッピングシステム『Ptex』

fSpy:1枚の写真からカメラパラメーターを割り出すツール

コメント